Архитектура персонального компьютера — online presentation

1. Архитектура персонального компьютера

2. Магистрально-модульный принцип построения компьютера

• Модульность позволяет потребителюсамому комплектовать нужную ему

конфигурацию компьютера и производить

при необходимости ее модернизацию.

• Модульная организация компьютера

опирается на магистральный (шинный)

принцип обмена информацией между

устройствами.

3. Магистраль — три различные шины,

через которые• подключаются процессор и оперативная

память, а также периферийные устройства

ввода, вывода и хранения информации;

• устройства обмениваются информацией в

форме последовательностей нулей и

единиц, реализованных электрическими

импульсами.

4. Чипсет

Современные компьютеры содержат двеосновные большие микросхемы чипсета:

контроллер-концентратор памяти, или

Северный мост (англ. North Bridge), который

обеспечивает работу процессора с оперативной

памятью и с видеоподсистемой;

контроллер-концентратор ввода/вывода, или

Южный мост (англ.

обеспечивающий работу с внешними

устройствами.

5. Пропускная способность шины

Пропускная способность шины (бит/с) равнапроизведению разрядности шины (в битах) и

частоты шины (в герцах — Гц, 1 Гц = 1 такт в

секунду):

пропускная способность шины = разрядность

шины * частота шины

Такт — это промежуток времени между подачами

электрических импульсов, синхронизирующих

работу устройств компьютера.

6. Системная шина – между Северным мостом и процессором (FSB от англ. FrontSide Bus).

Частота системной шины может составлять 400 МГц.Однако между Северным мостом и процессором эффективная

частота передачи данных в 4 раза выше.

Процессор может получать и передавать данные с частотой 400

МГц * 4 = 1600 МГц.

процессора и составляет 64 бита, то пропускная способность

системной шины равна:

64 бита * 1600 МГц = 102400 Мбит/с = = 100 Гбит/с = 12,5

Гбайт/с.

7. Частота процессора

В процессоре используется внутреннееумножение частоты, поэтому частота

процессора в несколько раз больше, чем

частота системной шины.

Это означает, что процессор за один такт шины

способен генерировать 8 своих внутренних

тактов и, следовательно, частота процессора

составляет

400 МГц * 8 = 3,2 ГГц.

8. Шина памяти – обмен данными между северным мостом и оперативной памятью

У современных модулей памяти (DDR3 от англ. double-data-rate) частотапамять получает данные с такой же частотой, что и процессор.

Так как разрядность шины памяти равна разрядности процессора и

составляет 64 бита, то пропускная способность шины памяти также

равна:

64 бита * 1600 МГц = 102 400 Мбит/с = = 100 Гбит/с = 12,5 Гбайт/с = 12

800 Мбайт/с.

Модули памяти маркируются своей пропускной способностью, выраженной

в Мбайт/с: РС4200, РС8500, РС12800 и др.

9. Шина PCI Express

Для подключения видеоплаты к северномумосту шина (Peripherial Component

взаимодействия периферийных устройств).

Пропускная способность этой шины может

достигать 32 Гбайт/с.

10. Шина SATA

Устройства внешней памяти (жесткие диски,CD- и DVD-дисководы) подключаются к

южному мосту по шине SATA (англ. Serial

Advanced Technology Attachment последовательная шина подключения

накопителей).

Скорость передачи данных по которой может

достигать 300 Мбайт/с.

11. Шина USB

Для подключения принтеров, сканеров, цифровыхкамер и других периферийных устройств обычно

используется шина USB (Universal Serial Bus универсальная последовательная шина).

Эта шина обладает пропускной способностью до 60

компьютеру одновременно до 127 периферийных

устройств (принтер, сканер, цифровая камера, Webкамера, модем и др.

).

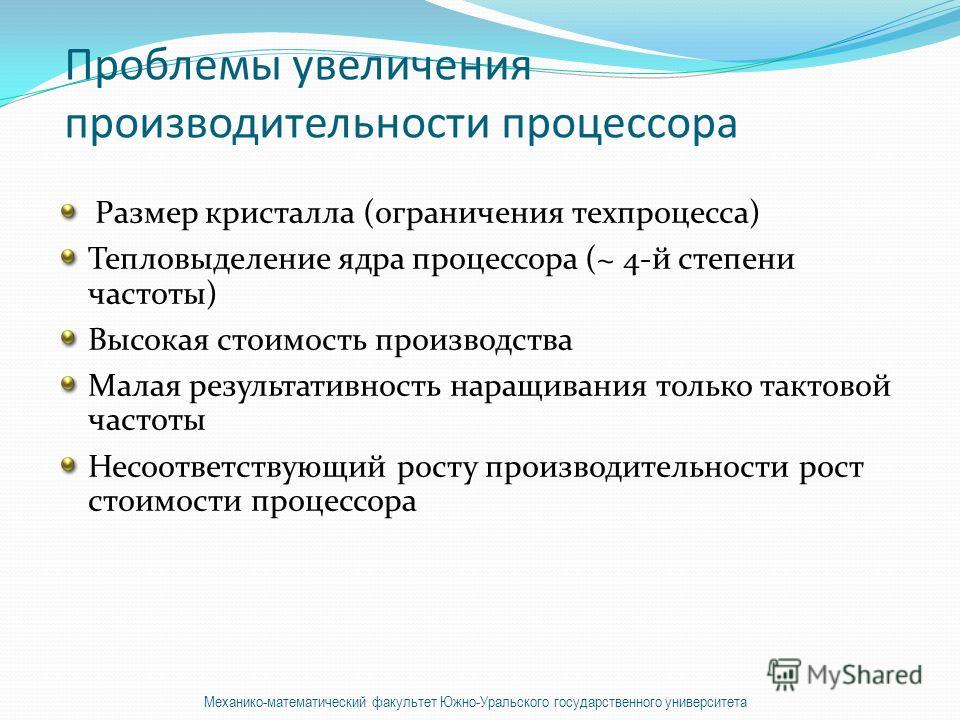

).12. Увеличение производительности процессора

Увеличение производительности процессоровза счет увеличения частоты имеет свой

предел из-за тепловыделения.

Выделение процессором теплоты Q

пропорционально потребляемой мощности

Р, которая, в свою очередь,

пропорциональна квадрату частоты v :

Q ~ Р ~ v2.

13. Архитектура персонального компьютера

14. Увеличение производительности процессора

Увеличение производительности процессора, азначит и компьютера, достигается за счет

увеличения количества ядер процессора

(арифметических логических устройств).

или четыре ядра, что позволяет распараллелить

вычисления и повысить производительность

процессора.

15. Контрольные вопросы

В чем состоит магистрально-модульныйпринцип построения компьютера?

Какие устройства обмениваются

информацией через Северный мост?

Какие устройства обмениваются

информацией через Южный мост?

В каком направлении развивается

архитектура процессоров?

Об устранении неполадок управления питанием в Windows 7

PowerCFG

PowerCFG является мощным средством командной строки, помогает при диагностике неполадок управления питанием.

Ниже перечислены наиболее распространенные команды, которые можно использовать для определения состояния сна и параметры по умолчанию.

-

POWERCFG -L или POWERCFG -LIST

Данная команда сначала. Эта команда выводит список всех схем управления питанием в текущей пользовательской среде. Схема управления питанием, перечисленных со звездочкой (*) – схему управления питанием.

-

POWERCFG -Q или POWERCFG-запрос

Во-вторых, используйте эту команду.

Затем можно определить точные параметры, которые применяются. Эта команда выводит содержимое схемы управления питанием. Для перенаправления списка в файл, используйте команду, подобную следующей:

Затем можно определить точные параметры, которые применяются. Эта команда выводит содержимое схемы управления питанием. Для перенаправления списка в файл, используйте команду, подобную следующей:Powercfg -Q > c:\test.txt

-

Wake_armed POWERCFG — DEVICEQUERY

Эта команда используется для определения устройств, которые установлены так, что пользователь может Разбудить компьютер.

Для мобильных ПК эта команда может показать устройства следующим образом:

-

Стандартной 101/102 клавиши

-

Клавиатура Microsoft Natural PS/2 с HP QLB

-

Сенсорная панель Synaptics PS/2 порт

Для настольного компьютера эта команда может показать устройства следующим образом:-

HID-совместимая мышь (002)

-

Broadcom NetXtreme Gigabit Ethernet

-

Устройство HID клавиатуры (002)

-

Дополнительные сведения о параметрах PowerCFG запустить POWERCFG /? команды.

Параметры командной строки Powercfg

Советы по устранению неполадок

Ниже приведены советы, что нужно учитывать при устранении неполадок управления питанием в Windows 7.

-

Каково назначение компьютера? Это мобильный ПК, опыт высокопроизводительные способствовать? Это сервер центра обработки данных класса с критически важных установлен SQL? Или это что-то между ними?

-

Есть ли в компьютере установлена новейшая версия BIOS? Это важно при исследовании проблемы питания.

-

Что такое установок BIOS, которые доступны? Просмотрите параметры BIOS.

Как правило пользователь может изменить параметры, влияющие на операционную систему. Изготовители оборудования могут предоставлять метод _OSC ACPI для включения операционной системы для настройки параметров BIOS. Например режим контроллера домена для мобильных ПК может задать уровень P-СОСТОЯНИЯ производительности Процессора. Операционная система сможет изменить этот параметр, если поставщик BIOS не разрешил операционной системе стать владельцем этого ресурса. ПВТ могут также настроить BIOS и оборудования таким образом, совместимые со стандартами набор нормативных требований. В этих случаях изменение параметров может оказаться вариант. Эти параметры могут даже не появляется в консоли управления питанием.

Как правило пользователь может изменить параметры, влияющие на операционную систему. Изготовители оборудования могут предоставлять метод _OSC ACPI для включения операционной системы для настройки параметров BIOS. Например режим контроллера домена для мобильных ПК может задать уровень P-СОСТОЯНИЯ производительности Процессора. Операционная система сможет изменить этот параметр, если поставщик BIOS не разрешил операционной системе стать владельцем этого ресурса. ПВТ могут также настроить BIOS и оборудования таким образом, совместимые со стандартами набор нормативных требований. В этих случаях изменение параметров может оказаться вариант. Эти параметры могут даже не появляется в консоли управления питанием. -

Были изменены параметры по умолчанию для схемы управления питанием? Чтобы определить это, с помощью команды POWERCFG -Q . Если изменены параметры по умолчанию, сброс текущей схемы управления питанием. Часто пользователь или системный администратор может настроить схемы управления питанием.

Помните, что групповая политика может применяться; Изменение политики питания, который управляется групповой политики продолжается только до входа в систему снова. Администратор может полностью заблокировать изменения или элементы из списка могут быть удалены из использования. На эти вопросы необходимо обратиться к администратору, а при использовании удаленного рабочего стола для внесения изменений необходимо подключиться с правами администратора. Главное помнить, что не все политики питания подходят для всех пользователей и их конкретного оборудования.

Помните, что групповая политика может применяться; Изменение политики питания, который управляется групповой политики продолжается только до входа в систему снова. Администратор может полностью заблокировать изменения или элементы из списка могут быть удалены из использования. На эти вопросы необходимо обратиться к администратору, а при использовании удаленного рабочего стола для внесения изменений необходимо подключиться с правами администратора. Главное помнить, что не все политики питания подходят для всех пользователей и их конкретного оборудования. -

Схемы управления питанием могут быть настроены администратором, приложением питания или с помощью групповой политики. Проверьте эти элементы, прежде чем продолжить устранение неполадок. Прежде чем запустить любой диагностики или восстановления схемы управления питанием с помощью параметра восстановить параметры по умолчанию для этого плана , должен сохранить текущие параметры с помощью POWERCFG-Экспорт команды.

Можно также нажать кнопку Создать план электропитания и затем настроить параметры настроенный план. При повреждении схем управления питанием, схем управления питанием можно восстановить настройки по умолчанию. Эта операция перезапишет все схемы по умолчанию.

Можно также нажать кнопку Создать план электропитания и затем настроить параметры настроенный план. При повреждении схем управления питанием, схем управления питанием можно восстановить настройки по умолчанию. Эта операция перезапишет все схемы по умолчанию.Чтобы восстановить схем управления питанием по умолчанию, выполните следующие действия.

-

Нажмите кнопку Пуск.

-

Введите команду cmdв поле Найти программы и файлы .

-

Щелкните правой кнопкой мыши CMDи нажмите кнопку Запуск от имени администратора.

-

В командной строке введите powercfg — restoredefaultschemesи нажмите клавишу ВВОД.

-

В командной строке введите exit для выхода из окна командной строки.

-

Перезагрузите компьютер.

-

-

Компьютер имеет ПВТ приложения управления питанием, установлена? Если это так, искать обновления и тестирования, отключите его. Во многих случаях ПВТ может дополнить политик управления питанием путем настройки политик для их конкретного устройства. Когда приложение управления питанием работает неправильно, обратитесь к производителю.

-

Просмотрите обновления Windows. Центр обновления Windows является ключевой элемент для просмотра. Кроме того убедитесь, что поиск в базе знаний Майкрософт об известных проблемах. Центр обновления Windows обновления драйверов, может относиться к текущей проблемы. Во многих случаях обновленные драйверы, перечислены в разделе «Дополнительно» Центр обновления Windows.

Часто задаваемые вопросы

Q1: Почему мой компьютер пробуждения ежедневно в 12:48 и запустите средство диагностики?

A1: Чтобы определить, почему это происходит, используйте параметр — WAKETIMERS для определения того, что в данный момент находится. Запланированными задачами являются одним из основных элементов, которые будут отображаться параметр — WAKETIMERS . Чтобы использовать этот параметр, выполните следующую команду:

POWERCFG — WAKETIMERSПримечание. Если компьютер является OEM-производителями, результаты данной команды может выглядеть следующим образом:

Истечения срока действия таймера задается имя_процесса\Device\HarddiskVolume2\Windows\System32\svchost.exe в 12:48:06 AM на 9/15/2010.

Причина: Планировщик заданий выполнит задачу «\OEM\OEM Assistant Application\First Boot».

Q2: Как определить все доступные сна?

A2: Используйте параметр — AVAILABLESLEEPSTATES . Чтобы сделать это, выполните следующую команду:

POWERCFG-AVAILABLESLEEPSTATESПример 1.

Ниже приведен пример сна на мобильных ПК у поставщика вычислительной Техники:

Следующие состояния спящего режима доступны в этой системе: ждущий режим (S3) Гибернация гибридный спящий режим

Следующие состояния спящего режима недоступны в данной системе:

Ждущий режим (S1)

Системные микропрограммы не поддерживают ждущий режим.

Ждущий режим (S2)

Системные микропрограммы не поддерживают ждущий режим.

Пример 2

Ниже приведен пример случая, в котором отключаются состояния сна. В этом примере был создан путем удаления текущий драйвер видеоадаптера и с помощью драйвера VGA. Драйвер VGA не поддерживает состояния сна и не опрашивать устройство для поддержки состояния спящий режим поддерживается. Windows опрашивает не только драйвер, но BIOS, прежде чем он позволяет любого состояния сна.

Следующие состояния спящего режима недоступны в данной системе:

Ждущий режим (S1)

Системные микропрограммы не поддерживают ждущий режим.

Внутренний системный компонент отключил ждущий режим.

Ждущий режим (S2)

Системные микропрограммы не поддерживают ждущий режим.

Внутренний системный компонент отключил ждущий режим.

Ждущий режим (S3)

Внутренний системный компонент отключил ждущий режим.

Спящий режим

Внутренний системный компонент отключил спящего режима.

Гибридный спящий режим

Примечание. Не забудьте проверить элемент Электропитание в панели управления и в BIOS компьютера, поскольку доступных режимов сна можно включить или отключить в этих местах.

Q3: Почему времени автономной работы на мобильном ПК на дисплее VGA уменьшить после Обновления до Windows 7 с Windows XP?

A3: Это общие проблемы, в котором отображения используется стандартный драйвер VGA. Этот драйвер не оптимизирован для видеокарты и будет потреблять больше энергии. Чтобы устранить эту проблему, обновите драйвер видеоадаптера.

Этот драйвер не оптимизирован для видеокарты и будет потреблять больше энергии. Чтобы устранить эту проблему, обновите драйвер видеоадаптера.

Q4: Почему не удается просмотреть некоторые параметры управления электропитанием?

A4: Windows 7 не удается отобразить параметры управления питанием, компьютер не поддерживает.

Вопрос 5: Как определить ли групповая политика действует и перезагрузки или рекомендацией конкретного питанием?

A5: Команда Gpresult . Эта команда отображает параметры питания применяются. Дополнительные сведения о команде Gpresult посетите следующий веб-узел Microsoft TechNet:

GpresultТакже схему управления питанием можно настроить с помощью настройки политики. Кроме того можно включить трассировку неполадок предпочтения, относящиеся к параметрам питания.

Вопрос 6: Как можно настроить схему управления питанием на месте, без перезапуска?

A6: С помощью команды POWERCFG — SETACTIVE {GUID} . Например выполните команду, подобную следующей:

Например выполните команду, подобную следующей:

8c5e7fda-e8bf-4a96-9a85-a6e23a8c635c — SETACTIVE POWERCFGЗапустите команду POWERCFG/l для просмотра изменений в режиме реального времени. Ниже приведен пример просмотра при выполнении команды POWERCFG/l :

Существующие схемы управления питанием (* активный)

GUID схемы питания: 381b4222-f694-41f0-9685-ff5bb260df2e (Сбалансированный)

GUID схемы питания: 8c5e7fda-e8bf-4a96-9a85-a6e23a8c635c (высокая производительность) *

GUID схемы питания: a1841308-3541-4fab-bc81-f71556f20b4a (энергосберегающая)

Q7: Компьютер работает медленно на «Энергосберегающая» схемы управления питанием и быстрее, чем ожидалось сток батареи. Что можно сделать? Выявлять, что происходит?

A7: Чтобы диагностировать проблему, создайте отчет питания. Чтобы сделать это, выполните следующие действия.

-

Нажмите кнопку Пуск.

-

n поле Найти программы и файлы типа cmd.

-

Щелкните правой кнопкой мыши CMDи нажмите кнопку Запуск от имени администратора.

-

В командной строке введите powercfg-энергии-вывода c:\temp\energy.html, и нажмите клавишу ВВОД.

-

В папке «Temp» откройте файл report.html энергию. Этот отчет использует 60 секунд выполнения. Тем не менее время отчета является настраиваемым. Просмотрите этот документ для ошибок и предупреждений. Информационный раздел содержит подробную информацию о плане политика питания и конфигурации компьютера во время теста.

В следующем примере показано несколько способов оптимизации работы батареи. Отчет содержит результаты, которые позволяют принимать обоснованные решения. Можно работать через всех ошибок и предупреждений для оптимизации компьютера.

Отчет содержит результаты, которые позволяют принимать обоснованные решения. Можно работать через всех ошибок и предупреждений для оптимизации компьютера.

Отчет о диагностике эффективности питания

Имя компьютера имя_компьютера

Время, Дата и время сканирования

Длительность 60 секунд сканирования

Производитель системы OEM_name

Название продукта системы product_name

Дата BIOS Дата

BIOS версии version_number

Операционная система построения build_number

PlatformRoleMobile роль платформы

Подключено в true

Счетчик процессов 72

Число потоков 742

Отчет GUID {GUID}

Результаты анализа

Ошибки

-

Политика питания: Dim таймаут отключен (питание от батареи)

Отображение не настроен на автоматическое затемнять после определенного периода бездействия. -

Политика питания: политика питания стандарта 802.

11 радио является максимальной производительности (на батареи)

11 радио является максимальной производительности (на батареи)

Текущая политика питания для адаптеров беспроводной сети 802.11-совместимый не настроен на использование режима пониженного энергопотребления. -

Политика питания: Dim таймаут отключен (питание от сети в)

Отображение не настроен на автоматическое затемнять после определенного периода бездействия. Средняя загрузка 7.38 (%)

Предупреждения

-

Политика питания: Время ожидания диска является длинная (питание от батареи)

Диск настроен на отключение после более чем 30 минут. Время ожидания (в секундах) 2400 -

Политика питания: Время ожидания выключения экрана велик (питание от сети в)

Отображение настроен на отключение после более 10 минут. Время ожидания (в секундах) 900

Время ожидания (в секундах) 900 -

Политика питания: политика питания стандарта 802.11 радио является максимальной производительности (питание от сети)

Текущая политика питания для адаптеров беспроводной сети 802.11-совместимый не настроен на использование режима пониженного энергопотребления.

Режим «производительность» повышает частоту смены кадров в Fortnite

УСКОРЕННАЯ ЗАГРУЗКА. ПОВЫШЕННОЕ БЫСТРОДЕЙСТВИЕ. ПОЛЬЗОВАТЕЛЯМ БОЛЕЕ СТАРЫХ КОМПЬЮТЕРОВ ДОСТУПЕН НОВЫЙ ПАРАМЕТР ДЛЯ ИГРЫ В FORTNITE.

Теперь пользователям компьютеров, отвечающих минимальным требованиям Fortnite, доступна альфа-версия режима «производительность». Его можно включить во внутриигровом меню параметров. Режим «производительность» позволит значительно повысить быстродействие, а также снизить расход оперативной памяти и нагрузку на процессор и видеокарту за счёт ухудшения качества изображения. Благодаря этому режиму у пользователей, которые играют при низких значениях параметров или на менее мощных компьютерах, игра будет работать лучше, чем прежде, а смена кадров станет стабильней.

Благодаря этому режиму у пользователей, которые играют при низких значениях параметров или на менее мощных компьютерах, игра будет работать лучше, чем прежде, а смена кадров станет стабильней.

Режим «производительность» в «дополнительных настройках графики».

Режим «производительность» доступен большинству игроков и работает только в «Королевской битве» и творческом режиме. Режим «производительность» можно в любой момент включить или отключить во внутриигровом меню параметров, после чего потребуется перезапустить игру.

Примечание: на ПК при включённом режиме «производительность» кампания «Сражение с Бурей» недоступна.

Экономия места на жёстком диске

Игроки также могут отказаться от текстур в высоком разрешении. Это можно сделать на странице настроек установки в программе запуска Epic Games. Следуйте этим инструкциям:

1. Откройте программу запуска Epic Games.

2. Выберите пункт «Библиотека».

3. Щёлкните по трём точкам рядом с надписью Fortnite.

4. Выберите «Параметры».

5. Уберите галочку рядом с опцией «Текстуры высокого разрешения».

Из файлов игры будет удалено около 14 ГБ материалов в высоком разрешении, так что итоговый размер игры составит всего 18 ГБ без всех дополнительных компонентов. Пользователям, которые играют при низких значениях параметров или с низким разрешением, это позволит освободить много места на диске за счёт небольшого ухудшения качества изображения!

Рекомендуемая конфигурация системы

Улучшение заметят все игроки, которые воспользуются режимом «производительность», но при определённой конфигурации системы игра будет работать ещё стабильнее. На более старых компьютерах с оперативной памятью 6 ГБ и больше или с игрой, установленной на диске SSD, расход памяти будет меньше, а рывки и зависания станут случаться реже. Наличие дискретной видеокарты не обязательно, однако она также поможет сбалансировать нагрузку на систему и сделает игровой процесс более комфортным.

Чего стоит ожидать?

В режиме «производительность» качество изображения в игре снизится, а частота смены кадров — повысится. Так в Fortnite смогут комфортно играть владельцы компьютеров, конфигурация которых отвечает минимальным требованиям. Наряду с возможностью удалить текстуры в высоком разрешении игра будет загружаться быстрее, чем когда-либо, причём на игровой процесс это никак не повлияет.

Ниже приведены средние значения частоты смены кадров в обычном матче для отрядов в игре, запущенной на ноутбуках с низкими значениями параметров, в сравнении с таким же матчем, но при включённом режиме «производительность». В обоих случаях выбрано разрешение 720p.

Конфигурация №1: | Конфигурация №2: |

ЦП: Intel i5-8265U (1,60 ГГц) | ЦП: AMD A10-5745M APU (2,1 ГГц) |

Оперативная память: 8 ГБ | Оперативная память: 6 ГБ |

Видеокарта: Intel UHD Graphics 620 | Видеокарта: AMD Radeon(TM) HD 8610G |

Частота смены кадров до: 24 кадра/с | Частота смены кадров до: 18 кадров/с |

Частота смены кадров после: 61 кадров/с | Частота смены кадров после: 45 кадров/с |

Режим «производительность» с разрешением 720p и отключёнными текстурами высочайшего качества.

ПОЗНАКОМЬТЕСЬ С FORTNITE В РЕЖИМЕ «ПРОИЗВОДИТЕЛЬНОСТЬ»!

Сменят ли ARM процессоры x86 и почему все зависит от Apple

В мире электроники два лагеря: мобильные гаджеты с процессорами ARM и классические компьютеры с x86. В статье разберемся в отличиях и изучим тренд, который задала Apple, перейдя на собственный ARM-чип M1 в настольных ПК

Какими бывают процессоры: x86 и ARM

В мобильных устройствах (планшеты, смартфоны) и классических компьютерах (ноутбуки, настольные ПК, серверы) используются разные процессоры. Они по-разному взаимодействуют с операционными системами и программами — взаимной совместимости нет. Именно поэтому вы не сможете запустить привычные Word или Photoshop на своем iPhone или Android-смартфоне. Вам придется скачивать из AppStore или Google Play специальную версию софта для мобильных устройств. И она будет сильно отличаться от версии для настольного ПК: как визуально, так и по функциональности, не говоря уже о программном коде, который пользователь обычно не видит.

Сверху — материнская плата iMac предыдущего поколения с процессором Intel (x86), снизу — плата iMac 2021 года с чипом M1 (ARM) (Фото: Apple)

Процессоры для классических компьютеров строятся на архитектуре x86. Своим названием она обязана ранним чипам компании Intel c модельными индексами 8086, 80186 и так далее. Первым таким решением с полноценной реализацией x86 стал Intel 80386, выпущенный в 1985 году. Сегодня подавляющее большинство процессоров в мире с архитектурой x86 делают Intel и AMD. При этом у AMD, в отличие от Intel, нет собственного производства: с 2018 года им по заказу компании занимается тайваньская корпорация TSMC.

Сегодня подавляющее большинство процессоров в мире с архитектурой x86 делают Intel и AMD. При этом у AMD, в отличие от Intel, нет собственного производства: с 2018 года им по заказу компании занимается тайваньская корпорация TSMC.

Процессор Intel 8086, 1978 год (Фото: wikipedia.org)

Когда Acer, Asus, Dell, HP, Lenovo и любые другие производители классических компьютеров используют процессоры Intel или AMD, то им приходится работать с тем, что есть. Они вынуждены закупать готовые решения без возможности гибко доработать чипы под свой конкретный продукт. А свои собственные процессоры на архитектуре x86 никто из производителей ПК делать не может. Дело не только в том, что это крайне сложно и дорого, но и в том, что лицензия на архитектуру принадлежит Intel, и компания не планирует ее ни с кем делить. AMD же воевала в американских судах за право создавать чипы на архитектуре x86 со своим главным конкурентом более десяти лет в 1980-х и 1990-х годах.

А свои собственные процессоры на архитектуре x86 никто из производителей ПК делать не может. Дело не только в том, что это крайне сложно и дорого, но и в том, что лицензия на архитектуру принадлежит Intel, и компания не планирует ее ни с кем делить. AMD же воевала в американских судах за право создавать чипы на архитектуре x86 со своим главным конкурентом более десяти лет в 1980-х и 1990-х годах.

Процессоры для мобильных устройств строятся на базе архитектуры ARM. И это не какая-то быстро и внезапно взлетевшая вверх молодая компания. Корни истории современной британской ARM Limited уходят далеко в 1980-е. Только в отличие от своих доминирующих на рынке «больших» ПК-конкурентов ARM Limited процессоры не делает. Бизнес компании построен на том, что она продает лицензии на производство чипов по своей технологии всем желающим. Причем возможности для доработки у лицензиатов максимально широкие — отсюда популярность и многообразие решений. Именно на основе архитектуры ARM Huawei делает свои мобильные чипы Kirin, у Samsung это Exynos, у Apple — серия Ax. В этот же список входят Qualcomm, MediaTek, NVIDIA и другие компании. А еще свои процессоры на ARM делает Fujitsu. Японцы назвали их A64X, и именно они в количестве 158 976 штук используются в самом мощном на момент выхода этой статьи суперкомпьютере в мире — Fujitsu Fugaku.

В этот же список входят Qualcomm, MediaTek, NVIDIA и другие компании. А еще свои процессоры на ARM делает Fujitsu. Японцы назвали их A64X, и именно они в количестве 158 976 штук используются в самом мощном на момент выхода этой статьи суперкомпьютере в мире — Fujitsu Fugaku.

Суперкомпьютер Fujitsu Fugaku (Фото: Riken)

Из открытого подхода ARM вытекает и главный недостаток: архитектура очень фрагментирована. Для x86 достаточно написать программу один раз, и она будет одинаково стабильно работать на всех устройствах. Для ARM приходится адаптировать софт под процессоры каждого производителя, что замедляет и удорожает разработку. Ну, а главный недостаток x86 вытекает из отсутствия конкуренции. В последние годы Intel, например, много упрекали за медленный или порой вовсе едва ощутимый прирост производительности от поколения к поколению. Также есть проблемы с высокими уровнями нагрева и энергопотребления.

Для ARM приходится адаптировать софт под процессоры каждого производителя, что замедляет и удорожает разработку. Ну, а главный недостаток x86 вытекает из отсутствия конкуренции. В последние годы Intel, например, много упрекали за медленный или порой вовсе едва ощутимый прирост производительности от поколения к поколению. Также есть проблемы с высокими уровнями нагрева и энергопотребления.

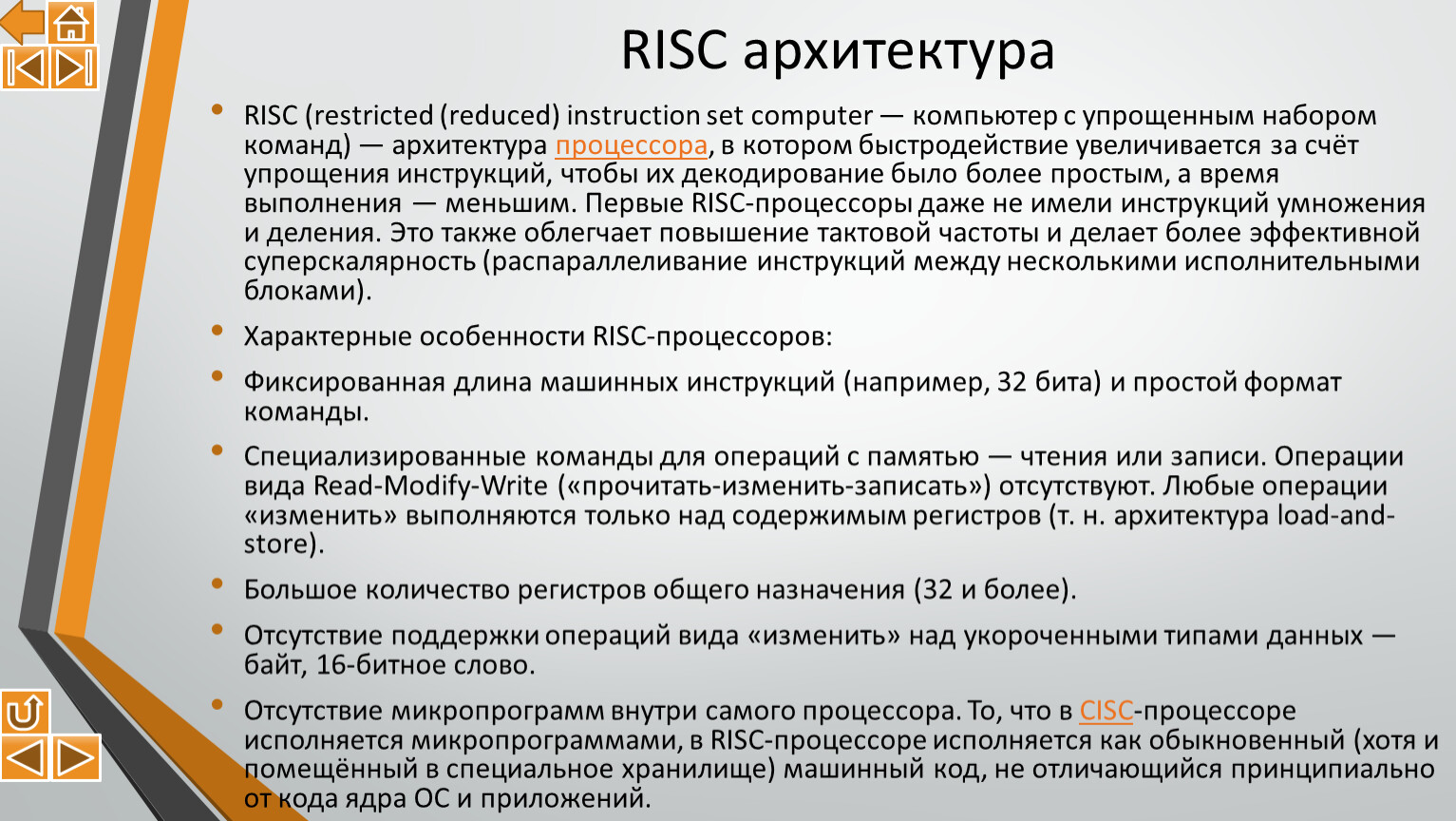

Архитектура процессоров: CISC, RISC, и в чем разница

Ключевое отличие между x86 и ARM кроется в разной архитектуре набора инструкций. По-английски — ISA, Instruction Set Architecture. В основе x86 изначально лежала технология CISC. Это расшифровывается как Complex Instruction Set Command — вычислительная машина со сложным набором инструкций. «Сложность» здесь в том, что в одну инструкцию для процессора может быть заложено сразу несколько действий.

Полвека назад, когда первые процессоры только появились, программисты писали код вручную (сейчас для этого есть компиляторы). Одну сложную команду на старом низкоуровневом языке программирования Assembler написать было гораздо проще, чем множество простых, досконально разъясняющих весь процесс. А еще сложная команда занимала меньше места, потому что код для нее был короче, чем несколько отдельных простых команд. Это было важно, потому что объем памяти в те времена был крайне ограничен, стоила она дорого и работала медленно. Заказчики от этого тоже выигрывали — под любой их запрос можно было придумать специальную команду.

А еще сложная команда занимала меньше места, потому что код для нее был короче, чем несколько отдельных простых команд. Это было важно, потому что объем памяти в те времена был крайне ограничен, стоила она дорого и работала медленно. Заказчики от этого тоже выигрывали — под любой их запрос можно было придумать специальную команду.

Но вот архитектура самого процессора страдала. По мере развития микроэлектроники в чипах с CISC копились команды, которые использовались редко, но все еще были нужны для совместимости со старыми программами. При этом под них резервировалось пространство на кристалле (место, где расположены физические блоки процессора). Это привело к появлению альтернативной технологии RISC, что расшифровывается как Reduced Instruction Set Command — вычислительная машина с сокращенным набором инструкций. Именно она легла в основу процессоров ARM и дала им название: Advanced RISC Machines.

Здесь ставку сделали на простые и наиболее востребованные команды. Да, код поначалу писать было сложнее, поскольку он занимал больше места, но с появлением компиляторов это перестало быть значимым недостатком. Результат — экономия места на кристалле и, как следствие, сокращение нагрева и потребления энергии. Плюс множество других преимуществ.

Да, код поначалу писать было сложнее, поскольку он занимал больше места, но с появлением компиляторов это перестало быть значимым недостатком. Результат — экономия места на кристалле и, как следствие, сокращение нагрева и потребления энергии. Плюс множество других преимуществ.

Почему о превосходстве ARM заговорили только недавно и при чем здесь Apple?

Если архитектура ARM так хороша, то почему же Intel и AMD не бросили все и не стали строить свои чипы на ней? На самом деле, они не оставили технологию без внимания, и к сегодняшнему дню CISC в чистом виде фактически уже не существует. Еще в середине 1990-х годов процессоры обеих компаний (начиная с Pentium Pro у Intel и K5 у AMD) обзавелись блоком преобразования инструкций. Сложные команды разбиваются на простые и затем выполняются именно там. Так что современные процессоры на архитектуре x86 в плане набора инструкций гораздо ближе к RISC, чем к CISC.

Кроме того, важно понимать, что противостояние x86 и ARM — это прежде всего противостояние Intel (потому что AMD гораздо меньше во всех отношениях: от капитализации до доли на рынках) и множества разрозненных производителей чипов для мобильных устройств. Долгое время два направления развивались как бы отдельно друг от друга. У Intel не получалось сделать достаточно мощное и энергоэффективное решение на x86 для мобильных устройств, а производители ARM-процессоров не стремились на рынок «больших» ПК. В нише мобильных устройств хватало места всем, и конкурировать там было проще, чем на фактически монополизированном Intel рынке процессоров для традиционных компьютеров.

Долгое время два направления развивались как бы отдельно друг от друга. У Intel не получалось сделать достаточно мощное и энергоэффективное решение на x86 для мобильных устройств, а производители ARM-процессоров не стремились на рынок «больших» ПК. В нише мобильных устройств хватало места всем, и конкурировать там было проще, чем на фактически монополизированном Intel рынке процессоров для традиционных компьютеров.

Однако в последние годы доминирующее положение Intel пошатнулось. Прежде всего из-за того, что бизнес компании перестал соответствовать ее же собственной производственной стратегии. Согласно прогнозу одного из основателей Intel Гордона Мура, количество транзисторов в процессорах должно удваиваться каждые два года за счет перехода на более компактный технологический процесс производства (измеряется в нанометрах — нм). Как раз за счет этого повышается производительность. Впоследствии впервые озвученный в середине 1960-х годов «Закон Мура» корректировался, но сегодня стало ясно, что бесконечным этот рост быть не может. Технологии Intel дошли до «потолка возможностей» и пока уперлись в него. Переход на 14 нм, а потом и на 10 нм сильно затянулся, в то время как AMD в партнерстве с TSMC уже работает по техпроцессу 7 нм, а первым 5-нанометровым процессором в мире стал Apple M1 на архитектуре ARM.

Технологии Intel дошли до «потолка возможностей» и пока уперлись в него. Переход на 14 нм, а потом и на 10 нм сильно затянулся, в то время как AMD в партнерстве с TSMC уже работает по техпроцессу 7 нм, а первым 5-нанометровым процессором в мире стал Apple M1 на архитектуре ARM.

О законе Мура на английском с русскими субтитрами

Решая множество технологических проблем с процессорами для «больших» компьютеров, Intel полностью упустила из вида рынок мобильных чипов, и теперь здесь господствуют решения ARM. Проблемы, кстати, при этом никуда не делись — чипы Intel для настольных ПК последних лет активно и справедливо критикуют. Мощные процессоры компании страдают от высокого нагрева и сильного энергопотребления, а энергоэффективные, наоборот, сильно ограничены в плане производительности.

Мощные процессоры компании страдают от высокого нагрева и сильного энергопотребления, а энергоэффективные, наоборот, сильно ограничены в плане производительности.

Большинство производителей ноутбуков и компьютеров продолжают с этим мириться, и не уходят на ARM — не позволяет огромный багаж популярного софта и массовость их техники. Как вы помните, одна и та же программа не сможет работать и на x86 и, на ARM — ее нужно обязательно программировать заново. Но в 2020 году после почти 15 лет выпуска компьютеров с процессорами Intel компания Apple объявила о переходе на процессоры ARM собственной разработки. Они, кстати, тоже производятся внешним подрядчиком: на заводах уже упомянутой TSMC.

И это крайне важное заявление, потому что на рынке только у Apple есть все возможности для того, чтобы сделать этот переход успешным. Во-первых, компания сама разрабатывает процессоры на базе ARM много лет. Настольные M1 «выросли»

из мобильных чипов серии Ax. У производителей ПК на других ОС такого опыта нет или он сильно ограничен. Во-вторых, у Apple огромный опыт разработки собственных операционных систем: как мобильной, так и настольной. Конкуренты в основном используют Windows или «надстройки» для Android.

Во-вторых, у Apple огромный опыт разработки собственных операционных систем: как мобильной, так и настольной. Конкуренты в основном используют Windows или «надстройки» для Android.

Остается совместить две системы (OS X для компьютеров, iOS для смартфонов), «заточенные» под разную архитектуру вместе, унифицировав софт, и это самый сложный пункт программы. Но и тут у Apple есть целая россыпь козырей. Это и лояльная аудитория, не готовая смотреть на продукцию конкурентов, но готовая подождать пока программы адаптируют под ARM. И собственный язык программирования Swift, который давно унифицировал процесс разработки ПО для iOS и OS X. И пусть небольшая в количестве устройств, но зато очень заметная доля на рынке ПК в деньгах, чтобы процесс адаптации «настольного» софта для x86 под работу с «мобильным» ARM стал интересен крупным разработчикам ПО. За примерами далеко ходить не надо: в Adobe на зов откликнулись одними из первых.

Немаловажно и то, что переход с Intel на ARM для Apple — далеко не первый опыт смены процессоров в своих устройствах. На Intel корпорация из Купертино переходила с PowerPC в 2005 году. А чипы PowerPC пришли на замену Motorola 68K в начале 1990-х.

На Intel корпорация из Купертино переходила с PowerPC в 2005 году. А чипы PowerPC пришли на замену Motorola 68K в начале 1990-х.

Стив Джобс о переходе на процессоры Intel в 2005 году

Процессор Apple M1: чем он так хорош?

Apple M1 интересен не столько тем, что построен на базе технологий ARM, сколько своей архитектурой. Здесь на одной подложке собраны сам процессор, в котором по 4 производительных и энергоэффективных ядра, восьмиядерная графическая подсистема, нейромодуль для машинного обучения, огромные (по меркам процессоров) объемы кэш-памяти плюс тут же распаяна оперативная память. Такое решение занимает совсем мало места в корпусе компьютера, потребляет мало энергии (аккумулятор ноутбука дольше не разрядится) и может работать без активного охлаждения (ноутбук будет тихим или вовсе бесшумным) при хорошем уровне производительности.

Чип Apple M1 в Macbook Air Late 2020 (Фото: iFixit)

И совсем не просто так первым компьютером Apple с процессором M1 стал MacBook Air. С одной стороны, это лэптоп, главными преимуществами которого как раз и должно быть все, что дает новый процессор: компактность, автономность, тишина. С другой стороны, это компьютер для наименее требовательных пользователей, которым практически не нужен никакой специфический софт — достаточно того, что сама Apple предлагает «из коробки»: браузера, проигрывателя, офисного пакета. А для софта, который под ARM адаптировать пока не успели, Apple использует встроенный эмулятор Rosetta 2.

А для софта, который под ARM адаптировать пока не успели, Apple использует встроенный эмулятор Rosetta 2.

Следующими ПК Apple с M1 после MacBook Air стали 13-дюймовый MacBook Pro и Mac Mini. Также недавно был анонсирован новый iMac. Такие машины уже ориентированы на задачи посерьезнее, но все равно это еще далеко не профессиональный сегмент — на него в Купертино пока лишь намекают. И именно здесь к решению Apple на базе технологий ARM возникает основной вопрос: получится ли «отмасштабировать» M1 до уровня профессиональных решений, где компактность и энергоэффективность не так важны, а на первый план выходит именно производительность? Как реализовать связку М1 с мощными дискретными видеокартами, без которых о монтаже, рендеринге и других сложных вычислениях говорить не приходится? Или может быть Apple вообще готовится к выпуску собственной дискретной графики? Вопросов пока куда больше, чем ответов на них.

Новая линейка тонких (11,5 мм) iMac 2021 на базе M1 (Фото: Apple)

Уже готовые компактные устройства Apple с чипами M1 выглядят действительно интересно, правда выигрыш в производительности в них явно ощущается в основном только в уже адаптированных под ARM программах, но зато он очень заметный. Так что если Intel и AMD не смогут дать достойный ответ конкуренту в нише энергоэффективных ПК, то рост популярности решений Apple не заставит себя ждать даже несмотря на то, что еще какое-то время софта будет не хватать. Массовому пользователю ведь много не нужно.

Так что если Intel и AMD не смогут дать достойный ответ конкуренту в нише энергоэффективных ПК, то рост популярности решений Apple не заставит себя ждать даже несмотря на то, что еще какое-то время софта будет не хватать. Массовому пользователю ведь много не нужно.

Сравнение производительности отдельных ядер на чипах M1 и Intel, больше — лучше (Фото: GeekBench)

Сравнение производительности всех ядер на чипах M1 и Intel, больше — лучше (Фото: GeekBench)

Придут ли процессоры ARM на смену x86?

Точного ответа на этот вопрос пока не знает никто. Но уже сейчас очевидно, что в ближайшие годы основная борьба x86 в лице Intel и ARM в лице Apple развернется на рынке компактных ноутбуков. Они, в отличие от неттопов (Mac Mini) и моноблоков (iMac), значительно более востребованы. Также очевидно и то, что пользователи от такого противостояния только выиграют.

Но уже сейчас очевидно, что в ближайшие годы основная борьба x86 в лице Intel и ARM в лице Apple развернется на рынке компактных ноутбуков. Они, в отличие от неттопов (Mac Mini) и моноблоков (iMac), значительно более востребованы. Также очевидно и то, что пользователи от такого противостояния только выиграют.

Конечно, техника (особенно у Apple) от этого не подешевеет, но зато мы прямо сейчас получили ультрапортативные лэптопы без активного охлаждения с долгожданным ощутимым приростом мощности и времени работы от батареи. Здорово и то, что разработчики Intel наконец-то взбодрятся. Из-за отсутствия конкуренции они слишком долго почивали на лаврах: самое время доставать из рукавов все припрятанные козыри. Собственно, именно так технологии и развиваются. Новый виток эволюции процессоров происходит прямо у нас на глазах, и ситуация выглядит так, что все вполне может обернуться революцией, которая полностью изменит как рынок процессоров, так и рынок компьютеров.

spydell — ЖЖ

Существует иллюзия истины в последней инстанции, некого абсолютного знания и понимая глубинных процессов мироздания у властьдержащих. Предположение, что там, на самом верху все известно и все решения, которые принимаются взвешенные, обдуманные, проанализированные со всех сторон и безусловно правильные, ведь им там сверху виднее, не так ли? Они располагают инсайдерской информацией, доступом к первичным данным по первому требованию и в любом объеме, у них самые мощные компьютеры, датацентры, лучшие умы и все требуемое, чтобы делать необходимые действия в нужное время. Так ли это? Нет, конечно.

Предположение, что там, на самом верху все известно и все решения, которые принимаются взвешенные, обдуманные, проанализированные со всех сторон и безусловно правильные, ведь им там сверху виднее, не так ли? Они располагают инсайдерской информацией, доступом к первичным данным по первому требованию и в любом объеме, у них самые мощные компьютеры, датацентры, лучшие умы и все требуемое, чтобы делать необходимые действия в нужное время. Так ли это? Нет, конечно.В действительности, самой емкой валютной системой в мире управляют долбанные ублюдки, которые ничего не контролируют, ничего не понимают, не соображают и не способны просчитывать действия даже на два шага вперед. Вся их аналитическая мощь сосредотачивается в отслеживании скользящей средней уже реализованной макроэкономической тенденции и самозаклинания «за все хорошее, против всего плохого». Проще говоря, они следуют за рынком, а не формируют этот рынок.

Каждый квартал ФРС выпускает прогнозы/оценки основных макроэкономических индикаторов (ВВП, безработица, инфляция, процентные ставки). История изменения прогнозов показывает то, каким образов эволюционирует представление ФРС о верхних пороговых значениях и траектории движения экономики и денежной системы. Во-первых, перед самым взлетом инфляции в 2021 году, ФРС в декабрьском обзоре ожидала 1.8% инфляции в 2021 и 1.9% в 2022.

История изменения прогнозов показывает то, каким образов эволюционирует представление ФРС о верхних пороговых значениях и траектории движения экономики и денежной системы. Во-первых, перед самым взлетом инфляции в 2021 году, ФРС в декабрьском обзоре ожидала 1.8% инфляции в 2021 и 1.9% в 2022.

Не важно, что происходит в мире, какие факторы и дисбалансы действуют на экономическую и монетарную систему, не имеет значения конфигурация межотраслевых связей. ФРС «заякоривает» в своих воспаленных умах то, что не имеет никакого значения к реальности. В этом смысле, если вы хотите понять то, в какую сторону все движется и пытаетесь использовать платформу ФРС для выстраивания прогнозов, то мимо. Содержательно, все их прогнозы дерьмо собачье, которое показывает не то, что будет и не то, что есть, а то, что они хотят. Отсюда следует, что любая риторика официальных представителей ФРС имеет ровно такую же пользу, как их прогнозы.

Во-вторых, что не менее важно, эти придурки даже не владеют арифметикой начальной школы. Их прогноз на инфляцию в 2021 составляет 4.2%, причем распределение голосов членов ФРС не выходит далеко за этот уровень.

Сейчас сентябрь, инфляция за 8 месяцев известна. Что значит 4.2% среднегодовых цен 2021 относительно 2020? Средний ИПЦ по индексу за 2020 составляет 258.84, а 4.2% инфляция это 269.71, что означает, что с сентября по декабрь 2021 включительно накопленный рост цен должен составить ровно НОЛЬ! то естественно невозможно, т.е эти болваны выпускают как бы актуальный прогноз под конец года, который не работает в момент выхода, что как бы символизирует о качестве аналитики ФРС. Управление инфляционными ожиданиями через постоянную ложь, блеф и манипуляции? Ну-ну, посмотрим насколько запаса доверия хватит… ( Читать дальше…Свернуть )

Как делают процессоры и что такое техпроцесс

Самый первый коммерческий микропроцессор в истории, Intel 4004, был представлен в 1971 году. Тогда это была революция — на его площади размещалось целых 2250 транзисторов. Всего через 7 лет, в 1978-ом, был представлен Intel 8086 с 29 тысячами транзисторов. И ровно через 42 года, в 2020-м, у нас есть Apple M1 — без прикрас революционный чип с 16 миллиардами транзисторов. А всё благодаря техпроцессу.

Сегодня такие производители, как TSMC освоили производство чипов, а вернее сказать транзисторов, по 5-нанометровой технологии. Чтобы вы наглядно понимали, насколько малы такие транзисторы — волос человека имеет толщину 80 тысяч нанометров — выходит, на его разрезе в теории можно разместить 16 тысяч транзисторов. Вирус COVID-19 имеет размер 110 нм и на нём можно разместить целых 22 транзистора от Apple M1.

Однако есть теории, что производители нам немного врут и за этими значениями нанометров, как правило, скрываются другие цифры. В этом материале мы разберём с вами в том, как вообще устроен техпроцесс, что в нём измеряют, затронем производство чипов, поймём преимущества уменьшения размеров транзисторов и заглянем в будущее.

Что делают транзисторы в процессорах

Любое вычислительное устройство, будь то компьютер, смартфон или ваши AirPods, работает в двоичной системе счисления. То есть все операции записываются, просчитываются и выводятся в последовательности нулей и единиц.

Транзистор в процессоре можно представить в роли своеобразного переключателя. Если ток через него проходит — это 1, если нет — то это 0. И таких переключателей в современных процессорах миллиарды. Разная последовательность нулей и единиц образует информацию — программы, музыку, картинки, видео и даже этот текст. Раньше роль транзисторов в первых ЭВМ выполняли вакуумные лампы.

Например, в ENIAC (это первый компьютер общего назначения) использовалось 17,5 тысяч вакуумных ламп. На этом компьютере производили вычисления для создания водородной бомбы, а ещё составляли прогнозы погоды и решали задачи из математики и физики. Суммарное энергопотребление этих 17 с половиной тысяч вакуумных ламп составляло целых 150 кВт, а сама ЭВМ требовала площадь для её сборки в 167 квадратных метров при весе в 27 тонн.

Само собой, всё это очень ограничивало технические возможности таких компьютеров, благо в январе 1959 года Роберт Нойс, по совместительству один из восьми основателей легендарной компании Fairсhild Semiconductor Company в Кремниевой долине, изобрёл интегральную схему на основе кремния, принципы которой легли в основу производства всех микропроцессоров.

Почему кремний?

Все чипы, которые производятся для массового рынка, делаются на кремниевой основе. Если не углубляться совсем в какие-то страшные и непонятные цифры с формулами, то причина кроется в атомной структуре кремния, которая идеально подходит для того, чтобы делать микросхемы и процессоры практически любой конфигурации.

Получают кремний, к слову, из песка. Да, самого обычного, который у вас есть на ближайшем берегу. Но вот в чём подвох — его чистота, если говорить в цифрах, составляет 99,5% (0,5% в таком кремнии составляют разные примеси). Может показаться, что это уже суперблизко к идеальной чистоте, но нет, для процессора необходимо, чтобы кремний имел чистоту 99,9999999%. Для этого материал проводят через цепочку определённых химических реакций. После этого кремний плавят и наращивают в один большой кристалл. Весит он под сотню килограмм и выглядит следующим образом:

После этот кристалл нарезается на пластины с диаметром около 30-сантиметров, которые тщательно шлифуются, чтобы не было никаких зазубрин. Дополнительно применяется ещё химическая шлифовка. Если хотя бы на одной пластине будут шероховатости — её забракуют. А вот готовые пластины кремния отправляют на дальнейшее производство.

Как создаются транзисторы процессора?

На отполированный кремниевый диск наносится специальный фоточувствительный слой, на который затем поступает поток света — он реагирует с молекулами слоя и изменяет свойства кремниевого диска. Этот процесс называется фотолитографией. В отдельных его частях после этого ток начинает проходить иначе — где-то сильнее, где-то слабее.

Затем этот слой покрывается изолирующим веществом (диэлектриком). После на него снова наносится специальный фоточувствительный слой и данный процесс повторяется несколько раз, чтобы на площади появились миллиарды мельчайших транзисторов. Которые потом ещё соединяют между собой, тестируют, разрезают на ядра, соединяют с контактами и упаковывают в корпус процессора.

Благодаря фотолитографии у инженеров есть возможность создания мельчайших нанометровых транзисторов. Однако, как оказывается, техпроцессом в разное время называли разные вещи.

«Он вам не техпроцесс»

Изначально техпроцессом производители обозначали длину затвора у транзистора. Затвор — это один из элементов транзистора, которым контролируется поток движения электронов. То есть, он решает — будет 0 или 1.

В соответствии с законом Гордона Мура (одного из основателей Intel), количество транзисторов в чипах удваивается в два раза каждые два года. Этот закон был им выведен в 1975 году сугубо на основе личных наблюдений, но они оказались в итоге верны.

За последние годы процессоры прибавили в количестве транзисторов, производительности, но не в размерах. Когда индустрия перешла с техпроцесса 1000 нм на 700 нм, производители обратили внимание, что другие элементы транзистора не так податливы уменьшению, в отличие от затворов. Однако и уменьшать затвор тоже уже было нельзя — потому что в таком случае электроны смогли бы проходить сквозь него и вызывать нестабильную работу чипа.

В 2012 году с переходом на 22-нанометровый техпроцесс инженеры придумали новый формат проектирование транзисторов — FinFET (от «fin» — рус. «Плавник»). Потому что он действительно стал похож на плавник рыбы.

Принцип заключается в увеличении длины канала, через который проходят электроны. За счёт этого в целом увеличивается площадь поверхности канала, что даёт возможность прохождения через него большему количеству электронов. С увеличением длины производители также получили возможность упаковки транзисторов с большей плотностью на один квадратный миллиметр.

Это, кстати, повысило производительность чипов за последние несколько лет, особенно в мобильных процессорах. Однако, из-за того что транзисторы перестали быть плоскими, став трёхмерными — это усложнило измерения их размера. Простите за тавтологию.

Разные производители, как правило, по-своему производят измерения. Например, Intel берут среднее значение двух размеров от наиболее распространённых ячеек. Кто-то делает иначе, однако в целом всё равно — нанометры, о которых говорят в графе «техпроцесс» являются чем-то усреднённым, но в целом значение практически полностью соответствует размеру одного транзистора. Но ещё, что важно в процессоре — это плотность размещения транзисторов.

Что важнее — нанометры или плотность

Многие ругают Intel за то, что они ещё не смогли выпустить свой коммерческий процессор на архитектуре 5 или 7 нм, как это делают Apple и Qualcomm. Но вот по плотности размещения транзисторов — Intel безусловный лидер. На один квадратный миллиметр 10 нм процессора Intel помещается на целых 5% больше транзисторов, чем в чипах от Apple, Qualcomm или AMD. Кстати, последние поколения процессоров от этих трёх брендов производит TSMC.

В интернете я наткнулся на сравнительную табличку процессоров Intel и TSMC:

Обратите внимание на 10- и 7-нанометровые чипы у Intel и TSMC соответственно. Размеры составляющих у них почти идентичны, поэтому 10-нанометров Intel не сильно-то и уступают 7 нм у TSMC. А вот по производительности, за счёт повышенной плотности транзисторов, как я уже сказал выше, даже выигрывают.

Однако, чем больше плотность — тем больше нагрев, поэтому чипы Intel не подойдут для использования в мобильной технике. Зато TSMC выигрывает в плане меньшего энергопотребления и тепловыделения.

А вот тут вы можете сказать — «стоп, но как Intel выдаёт больше производительности, если Apple M1, который производит TSMC разносит старые десктопные процессоры в пух и прах». Да, это действительно так, на деле Apple M1 действительно превосходит в вычислениях Intel, но причина тут не сколько в количестве транзисторов или техпроцессе, сколько в том, насколько эффективно процессор работает с этими транзисторами. В Intel x86 есть много лишних блоков команд, которые TSMC в некоторых производимых чипах, не использует. Об этом более подробно мы писали в отдельном материале с разбором x86 и Apple M1.

Так что дают нанометры

В действительности, уменьшение техпроцесса и правда положительно влияет на такие показатели, как энергопотребление и производительность. Однако многие нюансы в производстве чипов компании не раскрывают, и найти в интернете их невозможно. А из того, что есть — создаётся впечатление о множестве противоречий.

В целом я бы советовал воспринимать цифры, которые говорят нам производители чипов, как среднее значение от всех составляющих. Так что заявлять, что производители нам врут — нельзя, но и что нанометры полностью соответствуют действительности тоже нельзя. Влияет также то, по какому формату производятся эти чипы и какие применяются материалы. В любом случае — чем меньше техпроцесс, тем лучше.

Новая структура транзистора

Вполне возможно, что вместо уменьшения техпроцесса начнётся работа по изменению структуры создание транзисторов. К примеру, Samsung недавно анонсировали технологию Gate-All-Around FET (GAAFET) для технормы в 5 нм. Подобная структура транзистора обеспечивает вхождение электронов со всех сторон, что более эффективно.

На картинке выше вы можете увидеть, что гребень затвора не сплошной, а разделён на несколько нитей. Если подобное будет реализовано и в других чипах, тогда можно рассчитывать на повышение производительности в процессорах и понижение энергопотребления не уменьшением техпроцесса, а доведением до ума того, что есть сейчас.

Что ждать в будущем?

Летающие автомобили, киборги, путешествие со скоростью света и перемещение во времени — это всё фантастика. Но вот 3 нм или 1,4 нм чипы, вполне возможно, нет.

На сегодня известно, что Intel к 2029 году планируют освоить 1,4 нм техпроцесс, а TSMC уже начали исследование 2 нм. Для этого компании должны разработать новое оборудование для производства, обучить персонал и сделать многое другое.

Другой вопрос, что транзистор 1,4 нм по размерам сопоставим примерно с 10 атомами и это может плохо отразиться на производительности. Случайные электроны могут менять биты по несколько раз в секунду и тогда о стабильных вычислениях может не идти и речи. Может быть закон Мура уже не актуален и его эпоха просто подходит к концу, а мы ещё этого не понимаем?

Вопросы и ответы по Amazon EC2 – Amazon Web Services

Вопрос. Что такое спотовый инстанс?

Спотовые инстансы – это свободные ресурсы EC2, которые позволяют сэкономить до 90 % средств по сравнению с инстансами по требованию. При этом AWS может прервать работу спотовых инстансов после соответствующего уведомления, отправленного за 2 минуты. Для спотовых инстансов используются те же базовые инстансы EC2, что и для инстансов по требованию и зарезервированных инстансов, при этом спотовые инстансы лучше всего подходят для отказоустойчивых и гибких рабочих нагрузок. Спотовые инстансы – это дополнительный вычислительный ресурс, который можно использовать вместе с инстансами по требованию и зарезервированными инстансами.

Вопрос. Чем отличается спотовый инстанс от инстанса по требованию или зарезервированного инстанса?

Во время работы спотовые инстансы ничем не отличаются от инстансов по требованию или зарезервированных инстансов. Основное отличие состоит в стоимости спотовых инстансов, которые обычно оказываются дешевле инстансов по требованию. Кроме того, в зависимости от потребности в ресурсах Amazon EC2 может прервать работу инстансов после соответствующего уведомления, отправленного за 2 минуты до отключения. При этом спотовые цены постепенно корректируются в соответствии с долгосрочными тенденциями предложения и спроса на свободные ресурсы EC2.

Дополнительную информацию о спотовых инстансах см. здесь.

Вопрос. Как приобрести и запустить спотовый инстанс?

Спотовые инстансы можно запускать с помощью тех же инструментов, которые в настоящее время используются для запуска инстансов, включая Консоль управления AWS, группы Auto Scaling, команду запуска инстансов и спотовые группы. Кроме того, запуск спотовых инстансов поддерживают многие сервисы AWS, например EMR, ECS, Datapipeline, Cloudformation и Batch.

Для запуска спотового инстанса нужно просто выбрать шаблон запуска и указать количество инстансов, которое необходимо запросить.

Дополнительную информацию о запросе спотовых инстансов см. здесь.

Вопрос. Сколько спотовых инстансов может запросить пользователь?

Количество запрашиваемых спотовых инстансов должно быть в рамках лимита инстансов, установленного для каждого региона. Следует отметить, что для новых клиентов AWS установленное ограничение может иметь меньшее значение. Дополнительную информацию о лимитах для спотовых инстансов см. в Руководстве пользователя Amazon EC2.

При необходимости получения большего количества заполните документ Форма запроса инстанса Amazon EC2 с указанием примера их использования, после чего мы рассмотрим возможность увеличения количества инстансов. Увеличение лимитов распространяется на тот регион, для которого оно было запрошено.

Вопрос. Какая плата будет начисляться за использование спотовых инстансов?

Вы будете производить оплату по спотовой цене, которая действует для работающего инстанса в начале каждого инстанс-часа. Если цена на спотовый инстанс изменится после его запуска, это будет учтено при начислении платы со следующего часа работы инстанса.

Вопрос. Что такое пул спотовых ресурсов?

Пул спотовых ресурсов – это набор неиспользуемых инстансов EC2 с тем же типом инстанса, операционной системой, зоной доступности и сетевой платформой (EC2-Classic или EC2-VPC). Цены разных пулов спотовых ресурсов могут отличаться в зависимости от предложения и спроса.

Вопрос. Какие существуют рекомендации по использованию спотовых инстансов?

Настоятельно рекомендуется использовать несколько пулов спотовых ресурсов для максимального увеличения доступных спотовых ресурсов. EC2 предоставляет встроенные возможности автоматизации, позволяющие найти самые экономичные ресурсы среди множества пулов спотовых ресурсов с помощью спотовой группы, группы EC2 или EC2 Auto Scaling. Дополнительную информацию см. в Рекомендациях по использованию спотовых инстансов.

Вопрос. Как узнать состояние запроса на спотовые инстансы?

Состояние запроса на спотовые инстансы можно узнать с помощью кода состояния запроса на спотовые инстансы и соответствующего сообщения. Доступ к информации о состоянии запроса на спотовые инстансы можно получить на странице спотовых инстансов консоли EC2 в Консоли управления AWS, API и интерфейсе командной строки. Дополнительную информацию см. в Руководстве по Amazon EC2 для разработчиков.

Вопрос. Есть ли возможность заказывать спотовые инстансы любых семейств и размеров в любых регионах?

Спотовые инстансы доступны во всех публичных регионах AWS. Спотовые инстансы доступны практически для всех семейств и размеров инстансов EC2, включая самые новые типы инстансов: оптимизированные для вычислений, инстансы с применением графического ускорения и инстансы FPGA. Полный список типов инстансов, поддерживаемых в каждом регионе, см. здесь.

Вопрос. Какие операционные системы доступны на спотовых инстансах?

В список доступных систем входят Linux/UNIX, Windows Server и Red Hat Enterprise Linux (RHEL). Windows Server с SQL Server в настоящее время недоступна.

Вопрос. Можно ли использовать спотовый инстанс с платным AMI для стороннего программного обеспечения (например, программных пакетов IBM)?

В настоящий момент нет.

Вопрос. Могу ли я остановить запущенные мной спотовые инстансы?

Да, вы можете остановить запущенные спотовые инстансы, когда они не нужны, и сохранить их для последующего использования вместо их завершения или отмены запроса на спотовые инстансы. Остановить можно постоянные запросы на спотовые инстансы.

Вопрос. Как остановить спотовые инстансы?

Можно остановить свои спотовые инстансы, вызвав API StopInstances и предоставив идентификаторы для спотовых инстансов. Эти действия похожи на те, которые предпринимаются для остановки инстансов по требованию. Перевести инстанс в спящий режим можно в Консоли управления AWS, указав нужный инстанс, а затем выбрав «Actions > Instance State > Stop – Hibernate».

Вопрос. Как запустить остановленные спотовые инстансы?

Можно запустить остановленные спотовые инстансы, вызвав API StartInstances и предоставив идентификаторы для спотовых инстансов. Эти действия похожи на те, которые предпринимаются для запуска инстансов по требованию. Можно возобновить работу инстанса в Консоли управления AWS, указав нужный инстанс, а затем выбрав «Actions > Instance State > Start».

Примечание. Спотовые инстансы будут запущены, только если спотовые ресурсы все еще доступны в пределах вашей максимальной цены. Каждый раз, когда вы запускаете остановленный спотовый инстанс, он оценивает доступность ресурсов.

Вопрос. Как узнать, остановил ли я свой спотовый инстанс или его работа была прервана?

Узнать, был спотовый инстанс остановлен или все же его работа была прервана, можно с помощью кода состояния запроса на спотовые инстансы. Информация отображается как состояние запроса на спотовые инстансы на соответствующей странице в Консоли управления AWS или посредством ввода команды DescribeSpotInstanceRequests API в поле «status-code».

Если код состояния запроса на спотовые инстансы – «instance-stopped-by-user», это означает, что вы остановили свой спотовый инстанс.

Вопрос. Как будет начисляться плата, если работа моего спотового инстанса остановлена или прервана?

Если работа спотового инстанса будет прервана или остановлена Amazon EC2 во время первого часа работы инстанса, это время его использования оплачиваться не будет. Однако если вы завершите или остановите работу спотового инстанса самостоятельно, будет начислена плата с округлением до ближайшей секунды. Если работа спотового инстанса будет прервана или остановлена Amazon EC2 в любое время в течение любого последующего часа работы инстанса, будет начислена плата за фактическое время использования с округлением до ближайшей секунды. Если вы используете ОС Windows или Red Hat Enterprise Linux (RHEL) и при этом завершите или остановите работу спотового инстанса самостоятельно, будет начислена плата за полный час.

Вопрос. Когда работа моего спотового инстанса может быть прервана?

За последние 3 месяца 92 % прерываний работы спотовых инстансов происходили на стороне клиентов, которые вручную останавливали работу инстансов после завершения работы приложений.

EC2 может потребоваться отозвать спотовые инстансы, выделенные клиенту, по двум возможным причинам. Основная причина – это потребности в ресурсах Amazon EC2 (например, использование инстансов по требованию или зарезервированных инстансов). Во втором случае, если задан параметр «максимальная спотовая цена», при этом спотовая цена превысила указанную цену, через две минуты после соответствующего уведомления инстанс будет остановлен. Указанный параметр определяет максимальную цену, которую клиент готов заплатить за час работы спотового инстанса, при этом по умолчанию его значение соответствует цене инстанса по требованию. Как и прежде, работа спотовых инстансов будет оплачиваться по рыночной спотовой цене, действующей в момент запуска инстанса, а не по указанной максимальной цене, при этом плата будет начисляться на посекундной основе.

Вопрос. Что произойдет со спотовым инстансом, когда его работа будет прервана?

У клиентов есть возможность выбрать, что произойдет со спотовым инстансом, если его работа будет прервана: завершить работу, остановить или перевести в спящий режим. Остановка и перевод в спящий режим доступны для постоянных заявок на спотовые инстансы и спотовых групп с включенным параметром «maintain». По умолчанию работа инстансов завершается.

Дополнительную информацию об обработке прерываний см. в разделе, посвященном спящему режиму для спотовых инстансов.

Вопрос. В чем разница между остановкой и спящим режимом?

При переходе инстанса в спящий режим данные оперативной памяти сохраняются. В случае остановки инстанс отключается, а данные оперативной памяти удаляются.

В обоих случаях данные из корневого тома EBS и любых подключенных томов данных EBS сохраняются. Неизменным остается как частный IP‑адрес, так и эластичный IP‑адрес (если такой используется). Поведение на сетевом уровне будет аналогично тому, что описано для рабочего процесса EC2, связанного с остановкой‑запуском. Остановка и спящий режим доступны только для инстансов на базе Amazon EBS. Локальное хранилище инстансов не сохраняется.

Вопрос. Что делать, если объем корневого тома EBS недостаточен для сохранения состояния памяти (ОЗУ) для спящего режима?

Для записи данных из памяти на корневом томе EBS должно быть достаточно места. Если места на корневом томе EBS недостаточно, попытка перехода в спящий режим завершится ошибкой, при этом инстанс будет выключен. Убедитесь, что том EBS имеет достаточный объем для сохранения данных памяти, прежде чем выбирать спящий режим.

Вопрос. В чем преимущество перевода инстанса в спящий режим при прерывании его работы?

В спящем режиме работа спотовых инстансов в случае прерывания будет приостановлена и возобновлена, что позволяет продолжить выполнение рабочих нагрузок с момента остановки. Спящий режим можно использовать, если один или несколько инстансов должны сохранять свое состояние между циклами отключения-запуска, т. е. когда работа приложений, запущенных на спотовых инстансах, зависит от контекстных, деловых или сеансовых данных, хранящихся в ОЗУ.

Вопрос. Что нужно сделать, чтобы включить спящий режим для спотовых инстансов?

Дополнительную информацию о включении спящего режима для спотовых инстансов см. в разделе, посвященном спящему режиму для спотовых инстансов.

Вопрос. Будет ли взиматься плата за использование спящего режима для спотовых инстансов?

Дополнительная плата за использование спящего режима для инстанса не взимается. Оплачивается только хранилище EBS и любые другие используемые ресурсы EC2. При переводе инстанса в спящий режим плата за пользование инстансом не взимается.

Вопрос. Можно ли возобновить работу инстанса, находящегося в спящем режиме?

Нет. Нельзя напрямую возобновить работу инстанса, находящегося в спящем режиме. Amazon EC2 управляет циклами перехода в спящий режим, а также выхода из него. Если спотовый инстанс был переведен в спящий режим, он будет восстановлен Amazon EC2, когда ресурсы станут доступны.

Вопрос. Какие инстансы и операционные системы поддерживают спящий режим?

В настоящее время спящий режим для спотовых инстансов поддерживается для образов Amazon Linux AMI и операционных систем Ubuntu и Microsoft Windows, работающих на любом типе инстансов семейств C3, C4, C5, M4, M5, R3 и R4 с объемом памяти (RAM) до 100 ГиБ.

Перечень поддерживаемых версий ОС см. в разделе, посвященном спящему режиму для спотовых инстансов.

Вопрос. Как начисляется плата, если спотовая цена изменяется во время работы инстанса?

Оплачиваться будет полный час работы каждого инстанса с округлением до ближайшей секунды по ценам, которые устанавливаются в начале каждого инстанс-часа.

Вопрос. Где получить информацию об истории использования спотовых инстансов и платежах?

Консоль управления AWS создает подробный отчет о платежах, в котором указывается время запуска и завершения работы/остановки по каждому инстансу. Используя API, клиенты могут сравнить отчет о платежах с данными истории для проверки соответствия платежей и спотовых цен.

Вопрос. Будет ли прерываться работа блоков спотовых инстансов (спотовых инстансов фиксированной продолжительности)?

Блоки спотовых инстансов настроены на бесперебойную работу и будут работать непрерывно в течение всего заданного срока независимо от рыночной спотовой цены. В редких случаях работа блоков спотовых инстансов может прерываться из-за возросшего потребления ресурсов платформой AWS. В подобных случаях за две минуты до прекращения работы инстанса система выдает предупреждение (предупреждение о прекращении работы), при этом плата за работу затронутых инстансов взиматься не будет.

Вопрос. Что такое спотовая группа?

Спотовая группа позволяет автоматически запрашивать сразу несколько спотовых инстансов и управлять ими, что позволяет обеспечить наименьшую цену за единицу ресурсов для кластера или приложения, например задания пакетной обработки, рабочего процесса Hadoop или высокопроизводительных распределенных вычислений. Можно включать те типы инстансов, которые может использовать приложение. С учетом требований приложения задается необходимый объем ресурсов (можно указать количество инстансов, виртуальных ЦПУ, объем памяти, емкость хранилища или пропускную способность сети) и обновляется необходимый объем ресурсов после запуска группы. Спотовые группы позволяют запускать и поддерживать целевой уровень ресурсов, а также автоматически запрашивать ресурсы для замещения инстансов, работа которых была прервана или прекращена вручную. Подробнее о спотовых группах.

Вопрос. Взимается ли дополнительная плата за запросы на спотовые группы?

Нет, дополнительная плата за запросы на спотовые группы не взимается.

Вопрос. Какие существуют ограничения по запросам на спотовые группы?

Ознакомьтесь с разделом Ограничения для спотовых групп Руководства пользователя Amazon EC2, чтобы узнать о существующих ограничениях по запросам на спотовые группы.

Вопрос. Что происходит, если запрос на спотовую группу пытается запустить спотовые инстансы и при этом превышается ограничение на спотовые запросы для данного региона?

Если запрос на спотовую группу превышает ограничение на запросы спотовых инстансов для данного региона, отдельные запросы спотовых инстансов будут отклонены с состоянием «Превышено ограничение запросов на спотовую группу». В истории запросов на спотовые группы будут отображаться все ошибки, связанные с превышением ограничений на спотовые запросы. Ознакомьтесь с разделом Мониторинг спотовых групп Руководства пользователя Amazon EC2, чтобы узнать, как отобразить историю запросов на спотовые группы.

Вопрос. Есть ли гарантия, что запросы на спотовые группы будут выполнены?

Нет. Запросы на спотовые группы позволяют одновременно размещать запросы на несколько спотовых инстансов, при этом к ним применимы те же самые параметры доступности и цены, что и к запросам на отдельные спотовые инстансы. Например, если нет доступных ресурсов для типов инстансов, указанных в запросе спотовой группы, запрос не может быть выполнен частично или полностью. Рекомендуется включать в спотовую группу все возможные типы инстансов и зоны доступности, которые подходят для рабочих нагрузок.

Вопрос. Можно ли подать запрос на спотовую группу в нескольких зонах доступности?

Да. Ознакомьтесь с разделом Примеры спотовых групп Руководства пользователя Amazon EC2, чтобы узнать, как подать запрос на спотовую группу в нескольких зонах доступности.

Вопрос. Можно ли подать запрос на спотовую группу в нескольких регионах?

Нет, запросы на группы в нескольких регионах не поддерживаются.

Вопрос. Каким образом спотовые группы распределяют ресурсы между различными пулами спотовых инстансов, заданными в параметрах запуска?

API RequestSpotFleet позволяет воспользоваться одной из трех стратегий распределения: capacity‑optimized, lowestPrice и diversified. Стратегия распределения с оптимизацией ресурсов пытается выделить спотовые инстансы из пула с наибольшей доступностью, анализируя метрики ресурсов. Эта стратегия хорошо подходит для рабочих нагрузок с высокой стоимостью прерывания, к которым относятся большие данные и аналитика, рендеринг изображений и мультимедийного контента, машинное обучение и высокопроизводительные вычисления.

Стратегия lowestPrice позволяет распределять ресурсы спотовой группы между пулами инстансов с минимальной стоимостью единицы ресурсов на время передачи запроса. Стратегия diversified позволяет распределять ресурсы спотовой группы между несколькими пулами спотовых инстансов. Эта стратегия позволяет поддерживать целевой уровень ресурсов группы и повысить доступность приложения в процессе колебаний объема спотовых ресурсов.

Запуск ресурсов приложения в неоднородных пулах спотовых инстансов позволяет дополнительно сократить эксплуатационные расходы группы с течением времени. Подробности см. в Руководстве пользователя по Amazon EC2.

Вопрос. Возможно ли с помощью тега отметить запрос на спотовую группу?

Теги можно использовать, чтобы запросить запуск спотовых инстансов с помощью спотовой группы. Назначение тегов для самой группы не поддерживается.

Вопрос. Как посмотреть, к каким спотовым группам принадлежат мои спотовые инстансы?

Чтобы посмотреть, какие спотовые инстансы принадлежат к спотовой группе, укажите запрос на группу. Запросы на группы остаются доступны в течение 48 часов после прекращения работы всех спотовых инстансов. Дополнительную информацию об отображении запроса на спотовую группу см. в Руководстве пользователя Amazon EC2.

Вопрос. Можно ли изменить запрос на спотовую группу?

В настоящее время можно изменять только целевые ресурсы запроса на спотовую группу. Чтобы изменить другие параметры конфигурации запроса, вам может потребоваться отменить текущий запрос и отправить новый.

Вопрос. Можно ли указать различные образы AMI для каждого типа инстанса, который будет использоваться?

Да, для этого достаточно указать нужный образ AMI в каждой конфигурации запуска, которая указывается в запросе на спотовую группу.

Вопрос. Можно ли использовать спотовую группу вместе с сервисами Elastic Load Balancing, Auto Scaling или Elastic MapReduce?

Спотовую группу можно использовать с такими возможностями сервиса Auto Scaling, как отслеживание целевых значений, проверка работоспособности, метрики CloudWatch и т. д. Кроме того, можно подключать инстансы к балансировщикам нагрузки сервиса Elastic Load Balancing (как к Classic Load Balancer, так и к Application Load Balancer). В Elastic MapReduce есть функция под названием «Группы инстансов», которая предоставляет возможности, подобные возможностям спотовой группы.

Вопрос. Может ли запрос на спотовую группу прекратить работу спотовых инстансов, если они больше не выполняются в спотовом пуле с самой низкой ценой или оптимизацией по ресурсам, и затем повторно запустить их?

Нет, запросы на спотовые группы не предусматривают автоматического прекращения работы запущенных спотовых инстансов и повторного их запуска. Тем не менее,если пользователь прекращает работу спотового инстанса, спотовая группа заменит его новым спотовым инстансом из нового пула с самой низкой ценой или оптимизацией по ресурсам в соответствии с выбранной стратегией распределения.

Вопрос. Можно ли использовать со спотовой группой модели поведения, связанные с остановкой или переходом в спящий режим после прерывания работы?

Да. Остановка-запуск и спящий режим-возобновление работы поддерживаются спотовой группой при включенном параметре «maintain» группы.