Перевод денег по фотографии: новый сервис банка «Открытие»

Смартфон, фото, деньги. Как сделать денежный перевод, просто сфотографировав получателя

Фото: Банк Открытие«Открытие» стал первым в мире банком, запустившим сервис денежных переводов с карты на карту по фотографии получателя.

Теперь для перевода денег с одной банковской карты на другую достаточно сделать фото на смартфон или взять из фотогалереи изображение человека, которому вы хотите отправить деньги. Звучит фантастично? Тем не менее для перевода денег по фото нужно всего лишь установить на смартфон мобильное приложение «Открытие. Переводы». Дальше в дело вступает магия, или на самом деле биометрия. Технологию биометрической идентификации лиц от VisionLabs адаптировали для p2p-переводов при поддержке Open Garage, IT и digital-подразделения банка.

Биометрия — не просто модный тренд. Она стала одной из самых востребованных и быстро развивающихся технологий последних лет, а свои решения в 2016–2017 годах представили практически все лидеры IT-рынка: Apple, Samsung, Intel, Nvidia и другие. Локомотивом внедрения биометрических решений в нашу жизнь стали производители смартфонов, которые оснастили сканерами не только премиальные девайсы, но и массовые бюджетные аппараты. Так, например, именно благодаря им в результате распространения сканеров отпечатка пальцев в смартфонах, а также их прозрачной интеграции в операционные системы биометрия стала популярным средством защиты денег в мобильных банковских приложениях и в приложениях платежных систем.

Локомотивом внедрения биометрических решений в нашу жизнь стали производители смартфонов, которые оснастили сканерами не только премиальные девайсы, но и массовые бюджетные аппараты. Так, например, именно благодаря им в результате распространения сканеров отпечатка пальцев в смартфонах, а также их прозрачной интеграции в операционные системы биометрия стала популярным средством защиты денег в мобильных банковских приложениях и в приложениях платежных систем.

Аутентификация пользователей с помощью сканера отпечатков стала первой биометрической технологией, получившей массовое распространение. Теперь вместо того, чтобы вводить пин-код, который коварно забывается в самый нужный момент, вы прикладываете палец к сканеру мобильного телефона и затем оплачиваете покупку или входите в личный кабинет онлайн-банка.

В 2017 году к биометрии, основанной на сканировании отпечатков пальцев, прибавилась и технология распознавания визуальных образов.

Использование нейросетей и deep machine learning, всего того, что сейчас называют искусственным интеллектом, привело к настоящему прорыву в области компьютерного зрения. Появились и первые биометрические внедрения этой технологии в повседневную жизнь. Хайп вокруг iPhone X был спровоцирован в первую очередь технологией Face ID, используемой в этом смартфоне. Она позволяет идентифицировать пользователя по его визуальному образу с вероятностью ошибки одна к миллиону.

Появились и первые биометрические внедрения этой технологии в повседневную жизнь. Хайп вокруг iPhone X был спровоцирован в первую очередь технологией Face ID, используемой в этом смартфоне. Она позволяет идентифицировать пользователя по его визуальному образу с вероятностью ошибки одна к миллиону.

Так как современный смартфон превратился в настоящий многофункциональный гаджет, в том числе и в платежный инструмент, неудивительно, что биометрическое распознавание лиц пришло и в банковский сектор. Сочетание простоты использования и надежности превращает биометрию в идеальное средство идентификации человека.

Как это работает

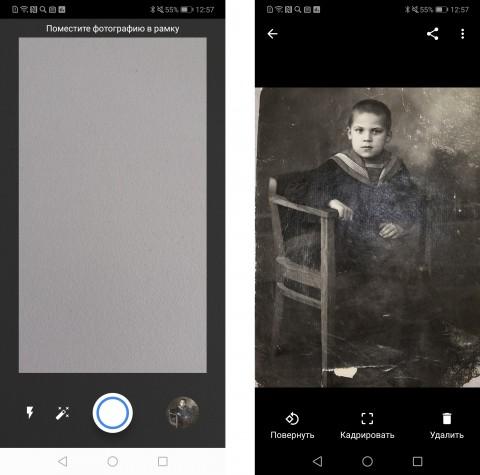

В меню мобильного приложения «Открытие. Переводы» вы выбираете «перевод по фото», делаете снимок получателя на камеру смартфона или просто берете его фотографию из галереи смартфона. Дальше начинается самое интересное. Фотография автоматически передается в банк, где происходит машинная идентификация получателя платежа с использованием биометрической системы распознавания лиц и базы клиентов банка (пока с помощью перевода по фотографии можно отправлять платежи только держателям карт банка «Открытие»). После этого вам остается только ввести сумму перевода и перевести деньги. Отправлять деньги можно с карты любого банка. В том случае, если карты, с которой отправляются денежные средства, нет в приложении, можно просто ввести ее реквизиты.

После этого вам остается только ввести сумму перевода и перевести деньги. Отправлять деньги можно с карты любого банка. В том случае, если карты, с которой отправляются денежные средства, нет в приложении, можно просто ввести ее реквизиты.

Фото: Банк Открытие

Преимущество способа заключается в том, что больше не нужно помнить 16 цифр номера банковской карты человека, которому отправляются деньги. Номер карты в самый ответственный момент можно забыть или просто не знать. Так, можно перевести деньги незнакомцу, чей номер телефона или карты вы просто не знаете, или быстро сфотографировать коллегу за обедом, чтобы не искать его контакт в телефонной книжке. Есть сотни самых неожиданных сценариев использования приложения, когда проще и удобнее отправить деньги по фотографии человека.

Да, получателем перевода по фотографии пока что может быть только клиент «Открытия». Однако в 2018 году такие переводы планируется сделать доступными и для клиентов других банков.

Да, за сохранность денег можно не волноваться, так как переводы проводятся по международному стандарту безопасности PCI DSS и подтверждаются 3D-secure кодом. История переводов сохраняется в приложении, так что всегда есть возможность проверить, куда и с какой карты были отправлены деньги, а также сохранить чек о выполненной операции.

История переводов сохраняется в приложении, так что всегда есть возможность проверить, куда и с какой карты были отправлены деньги, а также сохранить чек о выполненной операции.

Помимо перевода денег по фотографии получателя с помощью приложения «Открытие. Переводы», можно отправлять деньги «классическим» способом, по номеру телефона или по номеру карты — в последнем случае получатель может пользоваться картой любого российского банка.

Приложение доступно на платформах iOS и Android. Подробнее можно посмотреть здесь.

Добавить BFM.ru в ваши источники новостей?

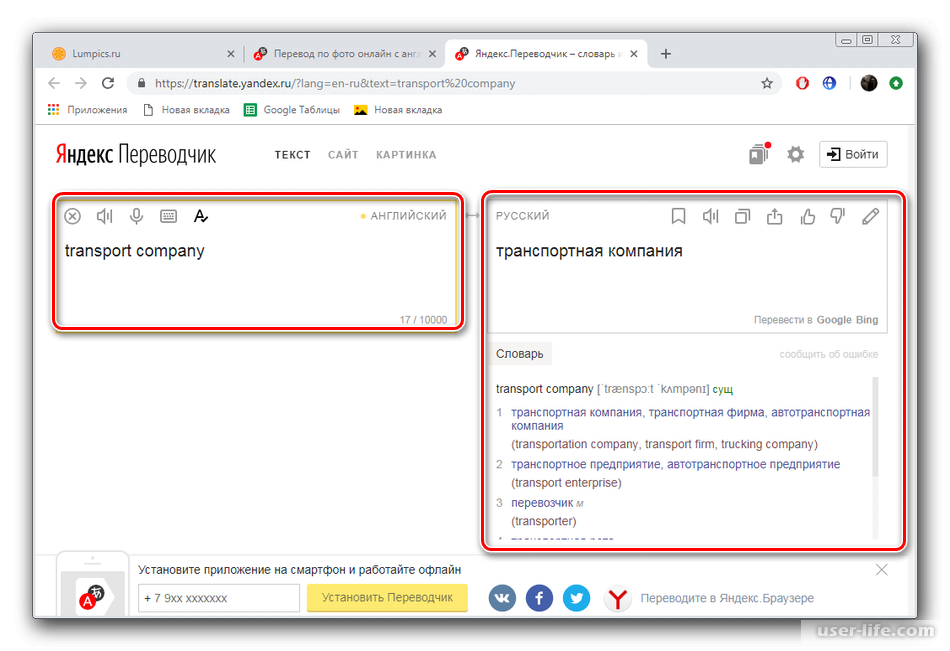

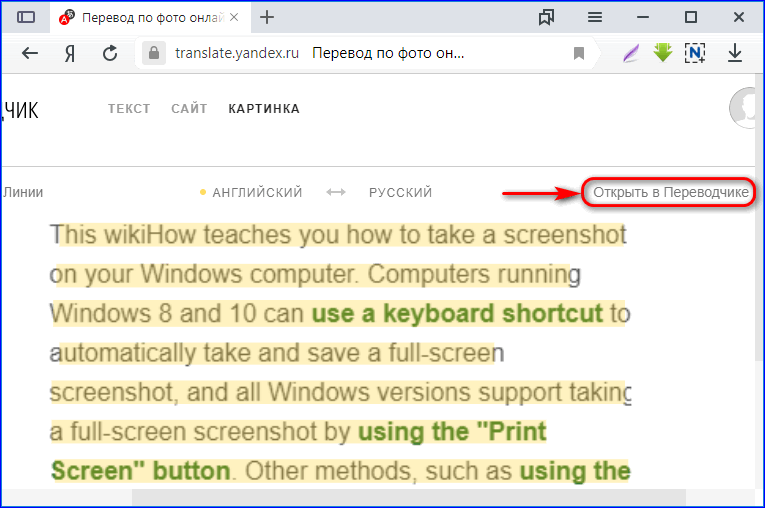

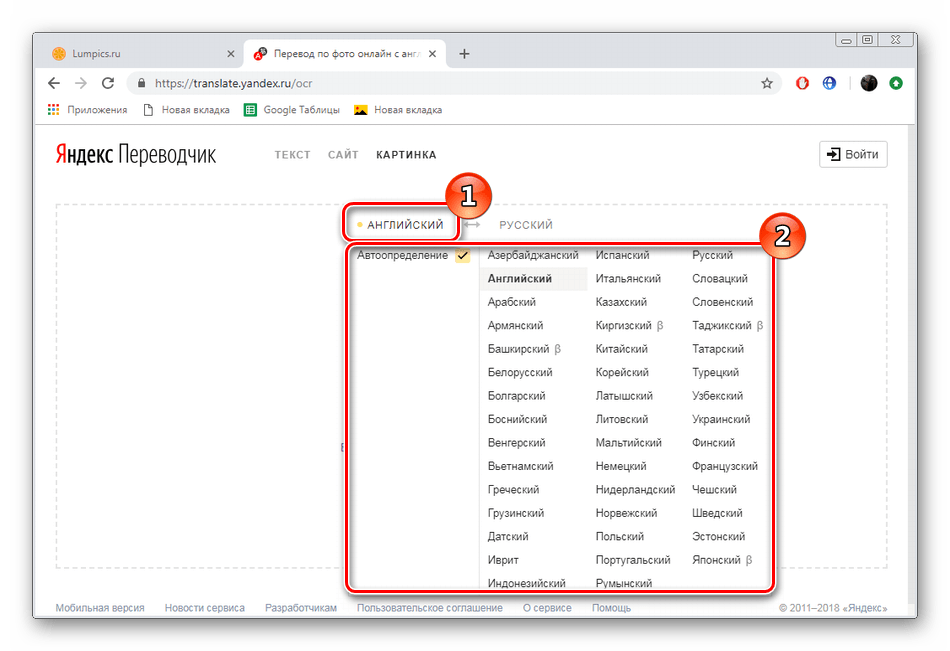

перевод, произношение, транскрипция, примеры использования

Вы не возражаете, чтобы сфотографировать нас вместе?

Её фотография была хорошо заметна на его письменном столе.

На данной фотографии вы видите наиболее активных представителей этой группы.

He looks very young in this photo. Mind you, it was taken years ago.

На этой фотографии он такой молодой! Впрочем, она была снята много лет назад.

The photo shows the American and Soviet leaders standing side by side on the lawn of the White House.

На фото изображены руководители США и СССР, стоящие рядом на лужайке перед Белым домом.

His photo stirred up bitter memories.

Его фото всколыхнуло горькие воспоминания.

His photo’s on the cover of Newsweek again.

Его фотография опять на обложке (журнала) «Ньюсуик».

You aren’t allowed to take photos inside the theater.

Вам не разрешается фотографировать внутри театра.

This photo was taken in Paris, if I remember rightly.

Эта фотография была сделана в Париже, если я правильно помню.

That photo makes me look ancient!

На этой фотографии мне лет сто, не меньше!

He looks much fatter than in his photo.

Он выглядит гораздо толще, чем на фотографии.

Stand on this side of me so Dad can get a photo.

Стань от меня с этой стороны, чтобы папа мог сделать фотографию.

The photo makes her look much older than she really is.

На этой фотографии она выглядит намного старше, чем есть на самом деле.

The photo had been retouched to remove the wrinkles around his eyes.

Фотографию отретушировали, чтобы убрать ему морщины вокруг глаз.

The photo doesn’t do her justice.

Эта фотография не передаёт всей её красоты.

Stick the photo onto the corkboard.

Прикрепите эту фотографию к доске объявлений.

She enclosed a photo with the card.

Она приложила к открытке фотографию.

Sue ripped his photo up into tiny bits.

Сью разорвала его фото на маленькие кусочки.

The photo shows a smiling, youthful Burgos.

На фотографии изображён молодой, улыбающийся Бургос.

She used glue to stick the photo in the album.

Она прикрепила фотографию в альбом с помощью клея.

The photo shows four men grouped round a jeep.

На фото показаны четверо мужчин, собравшихся вокруг джипа.

Perhaps this photo will help to jog your memory.

Возможно, это фото поможет освежить вашу память.

She fished around in her purse and pulled out a photo.

Она пошарила в сумочке и вытащила оттуда фотографию.

The cutline wrongly identified the people in the photo.

Люди, изображённые на фотографии, были подписаны неправильно.

We gave them a framed family photo for their anniversary.

На годовщину мы подарили им семейную фотографию в рамке.

Could the bride’s family all gather together for a photo?

Не могла бы вся семья невесты собраться вместе для фотографии?

She photoed the historic mansion for a decorating magazine.

Она сфотографировала этот старинный особняк для журнала, посвящённого ремонту.

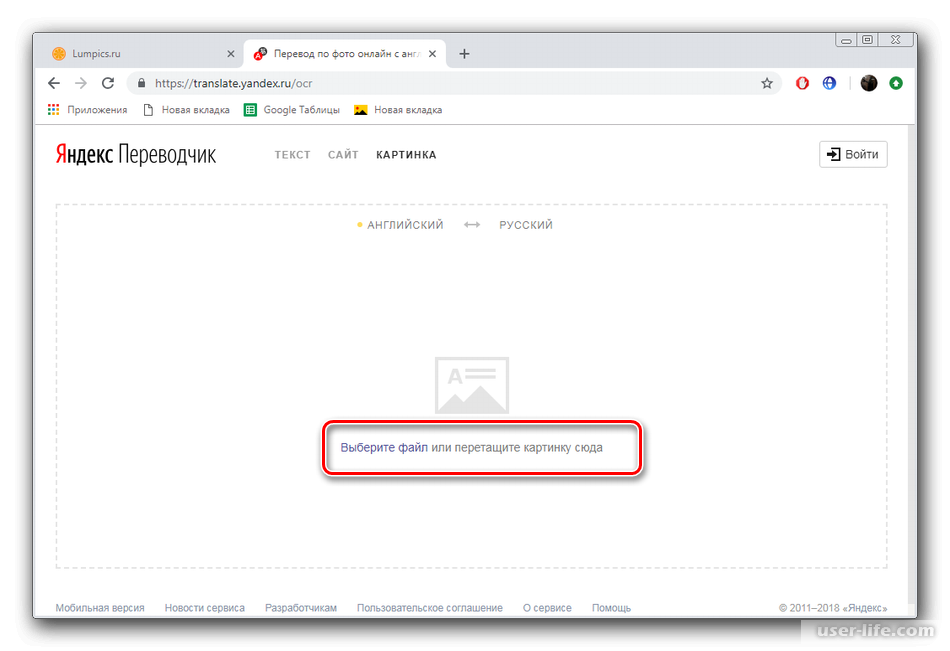

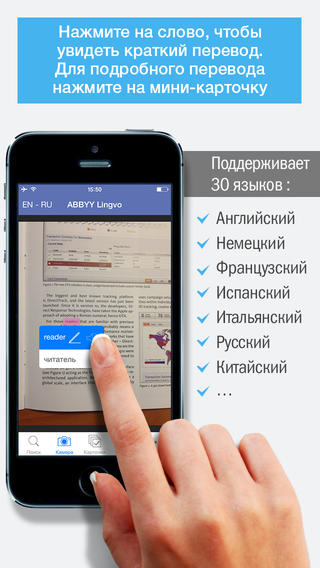

Air Перевод — Фото Переводчик — Приложение

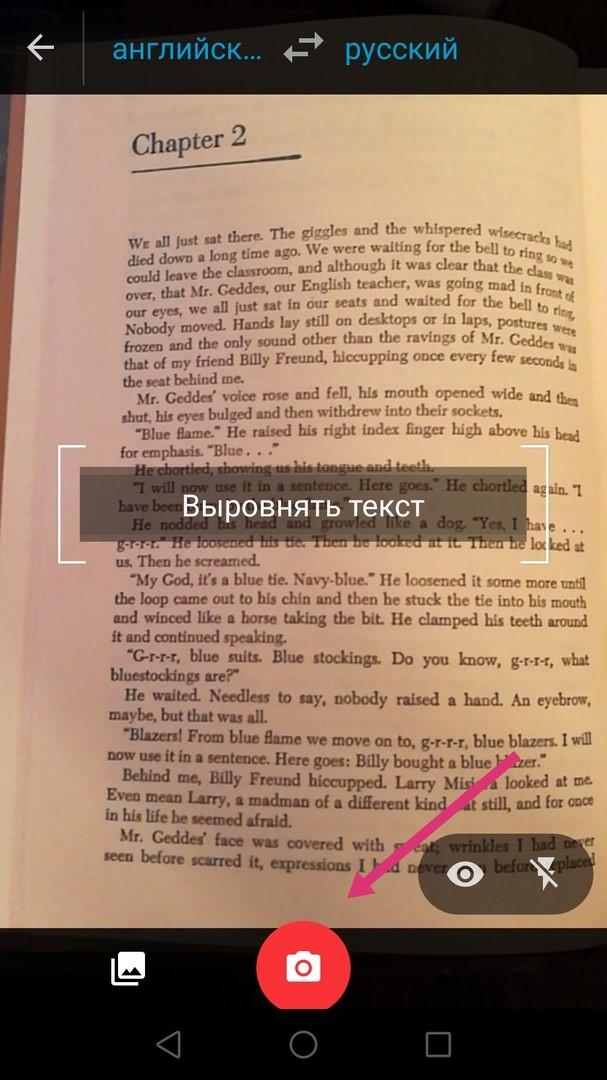

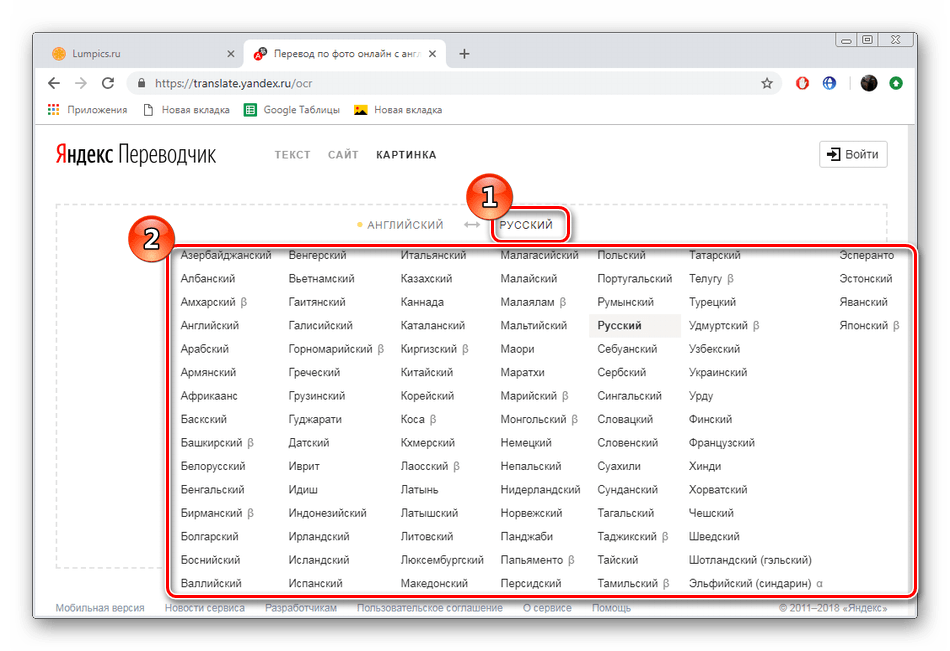

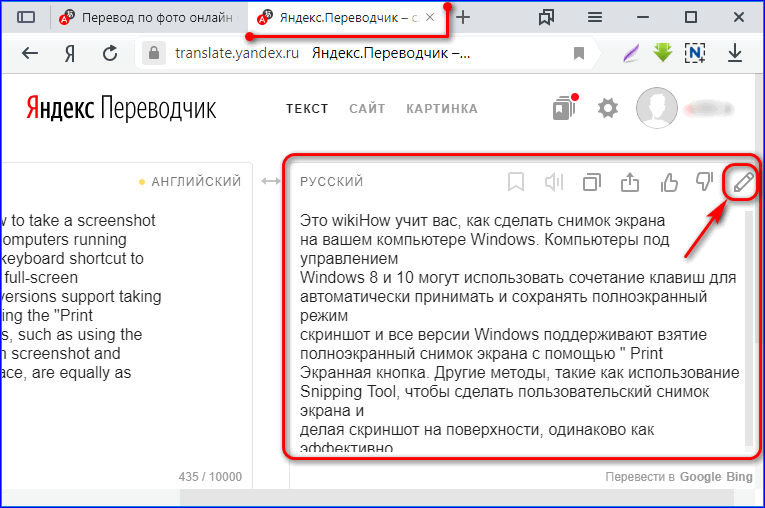

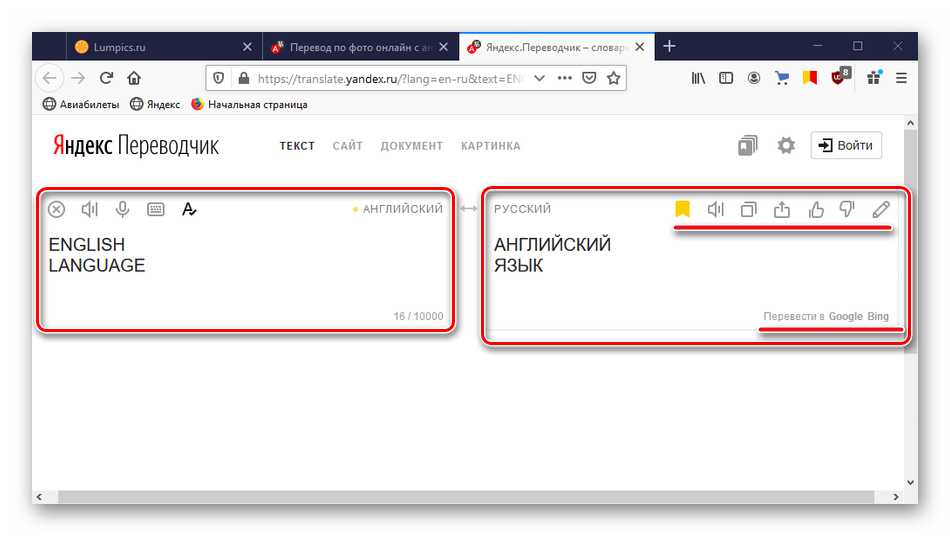

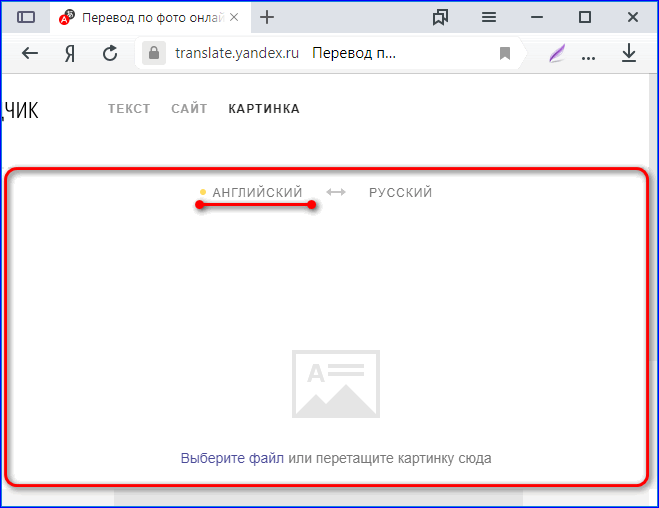

Используй камеру чтобы сканировать и переводить текста или документы. Определение объектов и локаций в один тап. Сделай фото и переводи что угодно! Сканирование текстов и документов еще никогда не было так просто. Просто сделай фото и наша искусственная система определит текст автоматически. Камера может сканировать большие документы на разных языках и переводить их на другие языки. Air Translate находка для бизнеса, путешествий и обучения. Переводи дорожные знаки, картинки, заголовки, документы, книги, инструкции, заметки, рекламу и многое многое другое. Распознавай объекты, локации, места, животных, растения, еду и другое. Слушай, читай, изменяй, переводи и делись этим за секунды! Изучай новые языки с помощью камеры! Проигрывай и слушай переводы, связывай их с фотографиями и запоминай новые слова. Все твои переводы сохраняются в историю так что ты можешь просматривать и практиковать их когда угодно! Твой прогресс не заставит ждать! Поддерживает языки:

Африкаанс, албанский, арабский, бангла, белорусский, болгарский, каталанский, китайский, хорватский, чешский, датский, голландский, английский, эсперанто, эстонский, филиппинский, финский, французский, галисийский, грузинский, немецкий, греческий, гуджарати, гаитянский креольский, иврит , Хинди, венгерский, исландский, индонезийский, ирландский, итальянский, японский, каннада, корейский, латышский, литовский, македонский, малайский, мальтийский, маратхи, норвежский, персидский, польский, португальский, румынский, русский, сербский, словацкий, словенский, испанский , Суахили, шведский, тагальский, тамильский, телугу, тайский, турецкий, украинский, урду, вьетнамский, валлийский, зулусский SUBSCRIPTION DETAILS

Choose from different subscription options.

Просто сделай фото и наша искусственная система определит текст автоматически. Камера может сканировать большие документы на разных языках и переводить их на другие языки. Air Translate находка для бизнеса, путешествий и обучения. Переводи дорожные знаки, картинки, заголовки, документы, книги, инструкции, заметки, рекламу и многое многое другое. Распознавай объекты, локации, места, животных, растения, еду и другое. Слушай, читай, изменяй, переводи и делись этим за секунды! Изучай новые языки с помощью камеры! Проигрывай и слушай переводы, связывай их с фотографиями и запоминай новые слова. Все твои переводы сохраняются в историю так что ты можешь просматривать и практиковать их когда угодно! Твой прогресс не заставит ждать! Поддерживает языки:

Африкаанс, албанский, арабский, бангла, белорусский, болгарский, каталанский, китайский, хорватский, чешский, датский, голландский, английский, эсперанто, эстонский, филиппинский, финский, французский, галисийский, грузинский, немецкий, греческий, гуджарати, гаитянский креольский, иврит , Хинди, венгерский, исландский, индонезийский, ирландский, итальянский, японский, каннада, корейский, латышский, литовский, македонский, малайский, мальтийский, маратхи, норвежский, персидский, польский, португальский, румынский, русский, сербский, словацкий, словенский, испанский , Суахили, шведский, тагальский, тамильский, телугу, тайский, турецкий, украинский, урду, вьетнамский, валлийский, зулусский SUBSCRIPTION DETAILS

Choose from different subscription options.

Перевод и переводчик с чешского на русский по фото, фотографии и картинке

Иногда нам присылают на перевод фотографии и фото с какими-то фразами, надписями или целыми текстами на чешском языке. Ведь у нас как раз профессиональные чеш переводчики для этих целей и работают. Они постоянно и каждодневно переводят разные тексты, стандартные документы и сложнейшую документацию с/на официальный язык Чехии. Так что и с вашим заданием справятся. Конечно, если вы позвоните нам или напишите. В самом низу этой статьи говорится, как это можно сделать.

Как перевести с чешского на русский по фото и фотографии?

Вряд ли у вас получится сделать это в каком-то онлайн сервисе (на сайте, в программе, приложении или тому подобном). Они обычный текст перевести толком не могут. А если вначале нужно еще его распознать с какого-то изображения или картинки, так и вовсе ситуация становится практически неразрешимой.

Перевод с фото или фотографии достойно и качественно вам сделает лишь живой и реальный чешский переводчик. Наши специалисты перевода чеш документов и документации такими заказами также занимаются. Они быстро распознают, что написано в присланном вами файле, а затем всё точно и грамотно переведут. Не зря ведь они изучали официальный язык Чехии в университете, а затем еще много лет занимались переводческой деятельности. Сейчас они максимально подготовлены к предоставлению таких вот услуг. Так что звоните нам или пишите, чтобы их получить.

Переводчик с чешского по фотографии или фото

Так вот у нас именно что живые и опытные чешские переводчики в Бюро работают. Профессиональные и грамотные специалисты перевода чеш текстов и документов. Так что они запросто переведут любые фразы и надписи с присланных вами картинок, фото, изображений и фотографий. Присылайте их нам или хотя бы позвоните проконсультироваться.

Так что они запросто переведут любые фразы и надписи с присланных вами картинок, фото, изображений и фотографий. Присылайте их нам или хотя бы позвоните проконсультироваться.

Как заказать перевод с чешского по фото, фотографии или картинке?

С любыми вопросами и уточнениями звоните по номеру ниже. Или сразу присылайте ваши фото и картинки через онлайн-заказ на этой странице или письмом на нашу электронную почту, чей адрес можно и здесь найти и в разделе Контакты нашего сайта.

А цену перевода с чешского на русский по вашим фотографиям или изображениям узнавайте по этому номеру Бюро чеш профессиональных переводчиков Гектор:

+7-922-181-08-30

Как разработать Pix2Pix GAN для преобразования изображения в изображение

Последнее обновление 18 января 2021 г.

Генеративная состязательная сеть Pix2Pix, или GAN, представляет собой подход к обучению глубокой сверточной нейронной сети для задач преобразования изображения в изображение.

Тщательная конфигурация архитектуры как типа GAN с условным изображением позволяет как создавать большие изображения по сравнению с предыдущими моделями GAN (например, 256 × 256 пикселей), так и способность хорошо работать с множеством различных изображений для -задачи по переводу изображений.

В этом руководстве вы узнаете, как разработать генерирующую состязательную сеть Pix2Pix для преобразования изображения в изображение.

После прохождения этого руководства вы будете знать:

- Как загрузить и подготовить спутниковое изображение в набор данных преобразования изображения в изображение карт Google.

- Как разработать модель Pix2Pix для перевода спутниковых снимков в изображения карты Google.

- Как использовать окончательную модель генератора Pix2Pix для перевода специальных спутниковых изображений.

Начните свой проект с моей новой книги «Генеративные состязательные сети с Python», включая пошаговые руководства и файлы исходного кода Python для всех примеров.

Приступим.

- Обновлено январь / 2021 : Обновлено, поэтому замораживание слоев работает с нормой партии.

Как разработать генерирующую состязательную сеть Pix2Pix для преобразования изображения в изображение

Фотография сделана Европейской южной обсерваторией, некоторые права защищены.

Обзор учебного пособия

Это руководство разделено на пять частей; их:

- Что такое Pix2Pix GAN?

- Набор данных преобразования изображений со спутника на карту

- Как разработать и обучить модель Pix2Pix

- Как переводить изображения с помощью модели Pix2Pix

- Как перевести карты Google на спутниковые изображения

Что такое Pix2Pix GAN?

Pix2Pix — это модель генерирующей состязательной сети или GAN, разработанная для универсального преобразования изображения в изображение.

Подход был представлен Филипом Изола и др. в своей статье 2016 года под названием «Преобразование изображения в изображение с использованием сетей с условным соперничеством», представленной на CVPR в 2017 году.

Архитектура GAN состоит из модели генератора для вывода новых вероятных синтетических изображений и модели дискриминатора, которая классифицирует изображения как реальные (из набора данных) или поддельные (сгенерированные). Модель дискриминатора обновляется напрямую, тогда как модель генератора обновляется через модель дискриминатора.Таким образом, две модели обучаются одновременно в состязательном процессе, в котором генератор пытается лучше обмануть дискриминатор, а дискриминатор пытается лучше идентифицировать поддельные изображения.

Модель Pix2Pix — это тип условного GAN, или cGAN, где создание выходного изображения зависит от входного, в данном случае исходного изображения. Дискриминатору предоставляется как исходное изображение, так и целевое изображение, и он должен определять, является ли цель правдоподобным преобразованием исходного изображения.

Генератор обучается через состязательную потерю, которая побуждает генератор генерировать правдоподобные изображения в целевой области. Генератор также обновляется с помощью потерь L1, измеряемых между сгенерированным изображением и ожидаемым выходным изображением. Эта дополнительная потеря побуждает модель генератора создавать правдоподобные переводы исходного изображения.

Генератор также обновляется с помощью потерь L1, измеряемых между сгенерированным изображением и ожидаемым выходным изображением. Эта дополнительная потеря побуждает модель генератора создавать правдоподобные переводы исходного изображения.

Pix2Pix GAN был продемонстрирован на ряде задач преобразования изображения в изображение, таких как преобразование карт в спутниковые фотографии, черно-белые фотографии в цветные и эскизы продуктов в фотографии продуктов.

Теперь, когда мы знакомы с Pix2Pix GAN, давайте подготовим набор данных, который мы можем использовать для преобразования изображения в изображение.

Хотите разрабатывать сети GAN с нуля?

Пройдите мой бесплатный 7-дневный ускоренный курс по электронной почте (с образцом кода).

Нажмите, чтобы зарегистрироваться, а также получите бесплатную электронную версию курса в формате PDF.

Загрузите БЕСПЛАТНЫЙ мини-курс

Набор данных преобразования изображений со спутника на карту

В этом уроке мы будем использовать так называемый набор данных « maps », который использовался в статье Pix2Pix.

Это набор данных, состоящий из спутниковых снимков Нью-Йорка и соответствующих страниц с картами Google. Проблема перевода изображений связана с преобразованием спутниковых фотографий в формат карт Google или, наоборот, изображений карт Google в спутниковые фотографии.

Набор данных представлен на веб-сайте pix2pix и может быть загружен в виде 255-мегабайтного zip-файла.

Загрузите набор данных и распакуйте его в текущий рабочий каталог. Будет создан каталог под названием « карты » со следующей структурой:

карты ├── поезд └── val

карты ├── поезд └── val |

Папка поезда содержит 1097 изображений, тогда как набор данных проверки содержит 1099 изображений.

Изображения имеют цифровое имя файла и находятся в формате JPEG. Каждое изображение имеет ширину 1200 пикселей и высоту 600 пикселей и содержит как спутниковое изображение слева, так и изображение Google Maps справа.

Пример изображения из набора данных Maps, включая изображение со спутника и Google Maps.

Мы можем подготовить этот набор данных для обучения модели Pix2Pix GAN в Keras. Мы просто будем работать с изображениями в наборе обучающих данных. Каждое изображение будет загружено, масштабировано и разделено на элементы спутниковой карты и карты Google.Результатом будет 1097 пар цветных изображений с шириной и высотой 256 × 256 пикселей.

Это реализует функция load_images () ниже. Он перечисляет список изображений в заданном каталоге, загружает каждое с целевым размером 256 × 512 пикселей, разбивает каждое изображение на элементы спутника и карты и возвращает массив каждого из них.

# загружаем все изображения из каталога в память

def load_images (путь, размер = (256,512)):

src_list, tar_list = список (), список ()

# перечисляем имена файлов в каталоге, предполагаем, что все изображения

для имени файла в listdir (путь):

# загрузить и изменить размер изображения

пикселей = load_img (путь + имя файла, target_size = размер)

# преобразовать в массив numpy

пикселей = img_to_array (пиксели)

# разделить на спутник и карту

sat_img, map_img = пикселей [:,: 256], пикселей [:, 256:]

src_list. добавить (sat_img)

tar_list.append (map_img)

возврат [asarray (src_list), asarray (tar_list)]

добавить (sat_img)

tar_list.append (map_img)

возврат [asarray (src_list), asarray (tar_list)]

# загрузить все изображения из каталога в память def load_images (path, size = (256,512)): src_list, tar_list = list (), list () # перечислить имена файлов в каталоге, предположим, что все являются изображениями для имени файла в listdir (путь): # загрузить и изменить размер изображения пикселей = load_img (путь + имя_файла, target_size = size) # преобразовать в массив numpy пикселей = img_to_array (пикселей) # разбить на спутник и карту sat_img, map_img = пикселей [:,: 256], пикселей [:, 256:] src_list.append (sat_img) tar_list.append (map_img) return [asarray (src_list), asarray (tar_list)] |

Мы можем вызвать эту функцию, указав путь к набору обучающих данных. После загрузки мы можем сохранить подготовленные массивы в новый файл в сжатом формате для дальнейшего использования.

Полный пример приведен ниже.

# загружать, разделять и масштабировать набор данных карт, готовый к обучению

из os import listdir

из numpy import asarray

из numpy import vstack

из кераса.preprocessing.image import img_to_array

из keras.preprocessing.image import load_img

из numpy import savez_compressed # загружаем все изображения из каталога в память

def load_images (путь, размер = (256,512)):

src_list, tar_list = список (), список ()

# перечисляем имена файлов в каталоге, предполагаем, что все изображения

для имени файла в listdir (путь):

# загрузить и изменить размер изображения

пикселей = load_img (путь + имя файла, target_size = размер)

# преобразовать в массив numpy

пикселей = img_to_array (пиксели)

# разделить на спутник и карту

sat_img, map_img = пикселей [:,: 256], пикселей [:, 256:]

src_list.добавить (sat_img)

tar_list.append (map_img)

возврат [asarray (src_list), asarray (tar_list)] # путь к набору данных

путь = ‘карты / поезд /’

# загрузить набор данных

[src_images, tar_images] = load_images (путь)

print (‘Загружено:’, src_images. shape, tar_images.shape)

# сохранить как сжатый массив numpy

filename = ‘maps_256.npz’

savez_compressed (имя файла, src_images, tar_images)

print (‘Сохраненный набор данных:’, имя файла)

shape, tar_images.shape)

# сохранить как сжатый массив numpy

filename = ‘maps_256.npz’

savez_compressed (имя файла, src_images, tar_images)

print (‘Сохраненный набор данных:’, имя файла)

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 18 19 20 21 22 23 24 25 26 27 28 29 31 | # загрузить, разделить и масштабировать набор данных карт, готовый для обучения из os import listdir from numpy import asarray from numpy import vstack from keras.preprocessing.image import img_to_array from keras.preprocessing.image import load_img from numpy import savez_compressed # загрузить все изображения из каталога в память def load_images (путь, размер = ( |

# перечислить имена файлов в каталоге, предположим, что все являются изображениями

для имени файла в listdir (путь):

# загрузить и изменить размер изображения

пикселей = load_img (путь + имя файла , target_size = size)

# преобразовать в массив numpy

пикселей = img_to_array (пикселей)

# разделить на спутник и карту

sat_img, map_img = пикселей [:,: 256], пикселей [:, 256:]

src_list. append (sat_img)

append (sat_img)

tar_list.append (map_img)

return [asarray (src_list), asarray (tar_list)]

# путь к набору данных

path = ‘maps / train /’

#

load dataset2 [src_images, tar_images] = load_images (путь)print (‘Loaded:’, src_images.shape, tar_images.shape)

# сохранить как сжатый массив numpy

filename = ‘maps_256.npz’

savez, src_images, tar_images)

print (‘Сохраненный набор данных:’, имя файла)

При выполнении примера загружаются все изображения в наборе обучающих данных, суммируются их формы, чтобы изображения были загружены правильно, а затем массивы сохраняются в новый файл с именем maps_256.npz в формате сжатого массива NumPy.

Загружено: (1096, 256, 256, 3) (1096, 256, 256, 3) Сохраненный набор данных: maps_256.npz

Загружено: (1096, 256, 256, 3) (1096, 256, 256, 3) Сохраненный набор данных: maps_256. |

Этот файл можно загрузить позже с помощью функции load () NumPy и получения каждого массива по очереди.

Затем мы можем построить несколько пар изображений, чтобы убедиться, что данные были обработаны правильно.

# загружаем подготовленный набор данных от нагрузки импорта numpy из matplotlib import pyplot # загрузить набор данных data = load (‘maps_256.npz’) src_images, tar_images = данные [‘arr_0’], data [‘arr_1’] print (‘Загружено:’, src_images.shape, tar_images.shape) # сюжет исходных изображений n_samples = 3 для i в диапазоне (n_samples): pyplot.subplot (2, n_samples, 1 + i) pyplot.axis (‘выключено’) pyplot.imshow (src_images [i] .astype (‘uint8’)) # построить целевое изображение для i в диапазоне (n_samples): пиплот.подзаговор (2, n_samples, 1 + n_samples + i) pyplot.axis (‘выключено’) pyplot.imshow (tar_images [i] .astype (‘uint8’)) pyplot.show ()

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 18 19 | # загрузить подготовленный набор данных из numpy import load из matplotlib import pyplot # загрузить набор данных data = load (‘maps_256. src_images, tar_images = data [‘ arr_0 ‘], data [‘ arr_1 ‘] print (‘ Loaded: ‘, src_images.shape, tar_images.shape) # построить исходные изображения n_samples для i в диапазоне (n_samples): pyplot.subplot (2, n_samples, 1 + i) pyplot.axis (‘off’) pyplot.imshow (src_images [i] .astype (‘uint8’) )) # построить целевое изображение для i в диапазоне (n_samples): pyplot.subplot (2, n_samples, 1 + n_samples + i) pyplot.ось (‘off’) pyplot.imshow (tar_images [i] .astype (‘uint8’)) pyplot.show () |

Выполнение этого примера загружает подготовленный набор данных и суммирует форму каждого массива, подтверждая наши ожидания немногим более тысячи пар изображений 256 × 256.

Загружено: (1096, 256, 256, 3) (1096, 256, 256, 3)

Загружено: (1096, 256, 256, 3) (1096, 256, 256, 3) |

Также создается график из трех пар изображений, показывающий спутниковые изображения вверху и изображения карты Google внизу.

Мы видим, что спутниковые изображения довольно сложны и, хотя изображения карты Google намного проще, они имеют цветовую кодировку для таких вещей, как основные дороги, вода и парки.

График из трех пар изображений, показывающий спутниковые изображения (вверху) и изображения Google Map (внизу).

Теперь, когда мы подготовили набор данных для перевода изображений, мы можем разработать нашу модель Pix2Pix GAN.

Как разработать и обучить модель Pix2Pix

В этом разделе мы разработаем модель Pix2Pix для перевода спутниковых фотографий в изображения Google Maps.

Та же архитектура и конфигурация модели, описанные в документе, использовались для решения ряда задач по переводу изображений. Эта архитектура описана как в основной части документа, с дополнительными подробностями в приложении к документу, так и в полностью работающей реализации, представленной как открытый исходный код с фреймворком глубокого обучения Torch.

Реализация в этом разделе будет использовать структуру глубокого обучения Keras, основанную непосредственно на модели, описанной в документе и реализованной в базе кода автора, предназначенной для получения и создания цветных изображений размером 256 × 256 пикселей.

Архитектура состоит из двух моделей: дискриминатора и генератора.

Дискриминатор — это глубокая сверточная нейронная сеть, которая выполняет классификацию изображений. В частности, условная классификация изображений. Он принимает как исходное изображение (например, спутниковое фото), так и целевое изображение (например, изображение Google Maps) в качестве входных данных и прогнозирует вероятность того, является ли целевое изображение реальным или поддельным переводом исходного изображения.

Дизайн дискриминатора основан на эффективном воспринимающем поле модели, которое определяет отношение между одним выходом модели и количеством пикселей во входном изображении.Это называется моделью PatchGAN и тщательно спроектировано таким образом, чтобы каждый выходной прогноз модели соответствовал квадрату или фрагменту входного изображения размером 70 × 70. Преимущество этого подхода заключается в том, что одна и та же модель может применяться к входным изображениям разных размеров, например. больше или меньше 256 × 256 пикселей.

больше или меньше 256 × 256 пикселей.

Выход модели зависит от размера входного изображения, но может представлять собой одно значение или квадратную карту активации значений. Каждое значение представляет собой вероятность того, что пятно во входном изображении является реальным.Эти значения могут быть усреднены для получения общей вероятности или классификационной оценки, если это необходимо.

Функция define_discriminator () ниже реализует модель дискриминатора 70 × 70 PatchGAN в соответствии с дизайном модели, описанной в статье. Модель берет два входных изображения, которые объединены вместе, и предсказывает исправление вывода предсказаний. Модель оптимизирована с использованием бинарной кросс-энтропии, и используется взвешивание, так что обновления модели дают половину (0,5) обычного эффекта.Авторы Pix2Pix рекомендуют это взвешивание обновлений модели, чтобы замедлить изменения дискриминатора по сравнению с моделью генератора во время обучения.

# определяем модель дискриминатора

def define_discriminator (image_shape):

# инициализация веса

init = RandomNormal (стандартное отклонение = 0,02)

# вход исходного изображения

in_src_image = Вход (shape = image_shape)

# ввод целевого изображения

in_target_image = Вход (shape = image_shape)

# объединить изображения по каналам

merged = Concatenate () ([in_src_image, in_target_image])

# C64

d = Conv2D (64, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (объединено)

d = LeakyReLU (альфа = 0. 2) (г)

# C128

d = Conv2D (128, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d)

d = BatchNormalization () (d)

d = LeakyReLU (альфа = 0,2) (d)

# C256

d = Conv2D (256, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d)

d = BatchNormalization () (d)

d = LeakyReLU (альфа = 0,2) (d)

# C512

d = Conv2D (512, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d)

d = BatchNormalization () (d)

d = LeakyReLU (альфа = 0.2) (г)

# второй последний выходной слой

d = Conv2D (512, (4,4), padding = ‘same’, kernel_initializer = init) (d)

d = BatchNormalization () (d)

d = LeakyReLU (альфа = 0,2) (d)

# вывод патча

d = Conv2D (1, (4,4), padding = ‘same’, kernel_initializer = init) (d)

patch_out = Активация (‘сигмоид’) (d)

# определить модель

model = Модель ([in_src_image, in_target_image], patch_out)

# скомпилировать модель

opt = Адам (lr = 0,0002, beta_1 = 0,5)

model.compile (loss = ‘binary_crossentropy’, optimizer = opt, loss_weights = [0.

2) (г)

# C128

d = Conv2D (128, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d)

d = BatchNormalization () (d)

d = LeakyReLU (альфа = 0,2) (d)

# C256

d = Conv2D (256, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d)

d = BatchNormalization () (d)

d = LeakyReLU (альфа = 0,2) (d)

# C512

d = Conv2D (512, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d)

d = BatchNormalization () (d)

d = LeakyReLU (альфа = 0.2) (г)

# второй последний выходной слой

d = Conv2D (512, (4,4), padding = ‘same’, kernel_initializer = init) (d)

d = BatchNormalization () (d)

d = LeakyReLU (альфа = 0,2) (d)

# вывод патча

d = Conv2D (1, (4,4), padding = ‘same’, kernel_initializer = init) (d)

patch_out = Активация (‘сигмоид’) (d)

# определить модель

model = Модель ([in_src_image, in_target_image], patch_out)

# скомпилировать модель

opt = Адам (lr = 0,0002, beta_1 = 0,5)

model.compile (loss = ‘binary_crossentropy’, optimizer = opt, loss_weights = [0. 5])

вернуть модель

5])

вернуть модель

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 18 19 20 21 22 23 24 25 26 27 28 29 30 000 3435 36 37 38 | # определение модели дискриминатора def define_discriminator (image_shape): # инициализация веса init = RandomNormal (stddev = 0.02) # исходное изображение input in_src_image = Input (shape = image_shape) # целевое изображение input in_target_image = Input (shape = image_shape) # объединять изображения по каналам merged (объединить) (объединить) [in_src_image, in_target_image]) # C64 d = Conv2D (64, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (объединено) d = LeakyReLU (альфа = 0,2) (d) # C128 d = Conv2D (128, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (альфа = 0. # C256 d = Conv2D (256, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization ( ) (d) d = LeakyReLU (alpha = 0.2) (d) # C512 d = Conv2D (512, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (alpha = 0.2) (d) # второй последний выходной слой d = Conv2D (512, (4,4), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (alpha = 0.2) (d) # вывод патча d = Conv2D (1, (4,4), padding = ‘same’, kernel_initializer = init) (d) patch_out = Activation (‘sigmoid’) (d) # определить модель model = Model ([in_src_image, in_target_image], patch_out) # compile model opt = Adam (lr = 0.0002, beta_1 = 0.5) model.compile (loss = ‘binary_crossentropy’, optimizer = opt, loss_weights = [0. модель возврата |

Модель генератора сложнее модели дискриминатора.

Генератор представляет собой модель кодера-декодера, использующую архитектуру U-Net. Модель берет исходное изображение (например, спутниковое фото) и генерирует целевое изображение (например, изображение Google Maps). Для этого сначала используется понижающая дискретизация или кодирование входного изображения до уровня узкого места, а затем повышающая дискретизация или декодирование представления узкого места до размера выходного изображения. Архитектура U-Net означает, что между уровнями кодирования и соответствующими уровнями декодирования добавляются пропускные соединения, образуя U-образную форму.

Изображение ниже проясняет пропускные соединения, показывая, как первый уровень кодера соединяется с последним уровнем декодера и так далее.

Архитектура генератора U-Net модели

, взятая из преобразования изображения в изображение с помощью условно состязательных сетей

Кодер и декодер генератора состоят из стандартизованных блоков сверточного, пакетного уровней нормализации, исключения и активации. Эта стандартизация означает, что мы можем разрабатывать вспомогательные функции для создания каждого блока слоев и многократно вызывать его для создания частей модели, кодирующих и декодирующих.

Эта стандартизация означает, что мы можем разрабатывать вспомогательные функции для создания каждого блока слоев и многократно вызывать его для создания частей модели, кодирующих и декодирующих.

Функция define_generator () ниже реализует модель генератора кодировщика-декодера U-Net. Он использует вспомогательную функцию define_encoder_block () для создания блоков слоев для кодера и функцию decoder_block () для создания блоков слоев для декодера. В выходном слое используется функция активации tanh, что означает, что значения пикселей в сгенерированном изображении будут в диапазоне [-1,1].

# определить блок кодировщика

def define_encoder_block (layer_in, n_filters, batchnorm = True):

# инициализация веса

init = RandomNormal (stddev = 0.02)

# добавить слой понижающей дискретизации

g = Conv2D (n_filters, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (layer_in)

# условно добавить пакетную нормализацию

если батчнорм:

g = BatchNormalization () (g, обучение = True)

# дырявая активация relu

г = LeakyReLU (альфа = 0,2) (г)

вернуть г # определяем блок декодера

def decoder_block (layer_in, skip_in, n_filters, dropout = True):

# инициализация веса

init = RandomNormal (стандартное отклонение = 0,02)

# добавить слой с повышающей дискретизацией

g = Conv2DTranspose (n_filters, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (layer_in)

# добавить пакетную нормализацию

g = BatchNormalization () (g, обучение = True)

# условно добавить отсев

если бросил:

g = выпадение (0. 5) (g, обучение = True)

# объединить с пропустить соединение

g = Concatenate () ([g, skip_in])

# активация relu

g = Активация (‘relu’) (g)

вернуть г # определить модель автономного генератора

def define_generator (image_shape = (256,256,3)):

# инициализация веса

init = RandomNormal (стандартное отклонение = 0,02)

# ввод изображения

in_image = Вход (shape = image_shape)

# модель кодировщика

e1 = define_encoder_block (in_image, 64, batchnorm = False)

e2 = define_encoder_block (e1, 128)

e3 = define_encoder_block (e2, 256)

e4 = define_encoder_block (e3, 512)

e5 = define_encoder_block (e4, 512)

e6 = define_encoder_block (e5, 512)

e7 = define_encoder_block (e6, 512)

# бутылочное горлышко, без партии norm и relu

b = Conv2D (512, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (e7)

b = Активация (‘relu’) (b)

# модель декодера

d1 = decoder_block (b, e7, 512)

d2 = decoder_block (d1, e6, 512)

d3 = decoder_block (d2, e5, 512)

d4 = decoder_block (d3, e4, 512, dropout = False)

d5 = decoder_block (d4, e3, 256, dropout = False)

d6 = decoder_block (d5, e2, 128, dropout = False)

d7 = decoder_block (d6, e1, 64, dropout = False)

# выход

g = Conv2DTranspose (3, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d7)

out_image = Активация (‘tanh’) (г)

# определить модель

model = Модель (in_image, out_image)

вернуть модель

5) (g, обучение = True)

# объединить с пропустить соединение

g = Concatenate () ([g, skip_in])

# активация relu

g = Активация (‘relu’) (g)

вернуть г # определить модель автономного генератора

def define_generator (image_shape = (256,256,3)):

# инициализация веса

init = RandomNormal (стандартное отклонение = 0,02)

# ввод изображения

in_image = Вход (shape = image_shape)

# модель кодировщика

e1 = define_encoder_block (in_image, 64, batchnorm = False)

e2 = define_encoder_block (e1, 128)

e3 = define_encoder_block (e2, 256)

e4 = define_encoder_block (e3, 512)

e5 = define_encoder_block (e4, 512)

e6 = define_encoder_block (e5, 512)

e7 = define_encoder_block (e6, 512)

# бутылочное горлышко, без партии norm и relu

b = Conv2D (512, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (e7)

b = Активация (‘relu’) (b)

# модель декодера

d1 = decoder_block (b, e7, 512)

d2 = decoder_block (d1, e6, 512)

d3 = decoder_block (d2, e5, 512)

d4 = decoder_block (d3, e4, 512, dropout = False)

d5 = decoder_block (d4, e3, 256, dropout = False)

d6 = decoder_block (d5, e2, 128, dropout = False)

d7 = decoder_block (d6, e1, 64, dropout = False)

# выход

g = Conv2DTranspose (3, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d7)

out_image = Активация (‘tanh’) (г)

# определить модель

model = Модель (in_image, out_image)

вернуть модель

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 18 19 20 21 22 23 24 25 26 27 28 29 30 000 3435 36 37 38 39 40 41 42 43 44 45 46 47 00030002 4700030002 47000351 52 53 54 55 56 57 58 59 60 61 | # определение блока кодера def define_encoder_block (layer_in, n_filters, batchnorm = True): # инициализация веса init = RandomNormal (stddev = 0.02) # добавить слой понижающей дискретизации g = Conv2D (n_filters, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (layer_in) # условно добавить пакетную нормализацию если batchnorm: g = BatchNormalization () (g, training = True) # Alucky Relu Activation g = LeakyReLU (alpha = 0.2) (g) return g # определить декодер block def decoder_block (layer_in, skip_in, n_filters, dropout = True): # инициализация веса init = RandomNormal (stddev = 0.02) # добавить слой с повышающей дискретизацией g = Conv2DTranspose (n_filters, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (layer_in) # добавить пакетную нормализацию g = BatchNormalization () (g, training = True) # условно добавить выпадение если выпадение: g = выпадение (0,5) (g, обучение = True) # слияние с пропуском соединения g = Concatenate () ([g, skip_in]) # повторная активация g = Activation (‘relu’) (g) return g # определение модели автономного генератора def define_generator (image_shape = ( 256,256,3)): # инициализация веса init = RandomNormal (stddev = 0.02) # image input in_image = Input (shape = image_shape) # модель кодировщика e1 = define_encoder_block (in_image, 64, batchnorm = False) e2 = define_encoder_block 9 = define_encoder_block (e2, 256) e4 = define_encoder_block (e3, 512) e5 = define_encoder_block (e4, 512) e6 = define_encoder_block (e5, 512) ck 9_b = define_encoder , без пакетной нормы и relu b = Conv2D (512, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (e7) b = Activation (‘relu’ ) (b) # модель декодера d1 = decoder_block (b, e7, 512) d2 = decoder_block (d1, e6, 512) d3 = decoder_block (d2, e5, 512) d4 = decoder_block (d3, e4, 512, dropout = False) d5 = decoder_block (d4, e3, 256, dropout = False) d6 = decoder_block (d5, e2, 128, dropout = False) d7 = decoder_block (d6, e1, 64, dropout = False) # output g = Conv2DTranspose (3, (4,4), strides = (2,2), padding = ‘same ‘, kernel_initializer = init) (d7) out_image = Activation (‘ tanh ‘) (g) # define model model = Model (in_image, out_image) return model |

Модель дискриминатора обучается непосредственно на реальных и сгенерированных изображениях, тогда как модель генератора — нет.

Вместо этого модель генератора обучается с помощью модели дискриминатора. Он обновлен, чтобы минимизировать потери, прогнозируемые дискриминатором для сгенерированных изображений, помеченных как « реальные ». Таким образом, рекомендуется создавать более реальные изображения. Генератор также обновляется, чтобы минимизировать потерю L1 или среднюю абсолютную ошибку между сгенерированным изображением и целевым изображением.

Генератор обновляется посредством взвешенной суммы как состязательных потерь, так и потерь L1, где авторы модели рекомендуют взвешивать 100: 1 в пользу потерь L1.Это сделано для того, чтобы генератор сильно побуждал генерировать правдоподобные переводы входного изображения, а не просто правдоподобные изображения в целевой области.

Это может быть достигнуто путем определения новой логической модели, состоящей из весов в существующей модели автономного генератора и дискриминатора. Эта логическая или составная модель включает в себя установку генератора поверх дискриминатора. Исходное изображение предоставляется как вход для генератора и дискриминатора, хотя выход генератора подключен к дискриминатору как соответствующее изображение « target ».Затем дискриминатор предсказывает вероятность того, что генератор был реальным переводом исходного изображения.

Дискриминатор обновляется автономно, поэтому веса повторно используются в этой составной модели, но помечены как не обучаемые. Составная модель обновляется двумя целями, одна из которых указывает, что сгенерированные изображения были реальными (кросс-энтропийная потеря), заставляя большие обновления веса в генераторе генерировать более реалистичные изображения, и выполненный реальный перевод изображения, который сравнивается с выход модели генератора (потеря L1).

Функция define_gan () ниже реализует это, принимая уже определенные модели генератора и дискриминатора в качестве аргументов и используя функциональный API Keras для их соединения в составную модель. Обе функции потерь указаны для двух выходных данных модели, а веса, используемые для каждого, указаны в аргументе loss_weights функции compile () .

# определить комбинированную модель генератора и дискриминатора для обновления генератора def define_gan (g_model, d_model, image_shape): # сделать веса в дискриминаторе необучаемыми для слоя в d_model.слои: если не isinstance (слой, BatchNormalization): layer.trainable = Ложь # определяем исходное изображение in_src = Вход (shape = image_shape) # подключаем исходное изображение ко входу генератора gen_out = g_model (in_src) # подключаем вход источника и выход генератора ко входу дискриминатора dis_out = d_model ([in_src, gen_out]) # src image как вход, сгенерированное изображение и вывод классификации model = Модель (in_src, [dis_out, gen_out]) # скомпилировать модель opt = Адам (lr = 0.0002, beta_1 = 0,5) model.compile (loss = [‘binary_crossentropy’, ‘mae’], optimizer = opt, loss_weights = [1,100]) вернуть модель

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 18 | # определить комбинированную модель генератора и дискриминатора, для обновления генератора def define_gan (g_model, d_model, image_shape): # сделать веса в дискриминаторе не обучаемыми для слоя в d_model.Layers: if not isinstance (layer, BatchNormalization): layer.trainable = False # определить исходное изображение in_src = Input (shape = image_shape) # подключить исходное изображение ко входу генератора gen_out = g_model (in_src) # подключите вход источника и выход генератора к входу дискриминатора dis_out = d_model ([in_src, gen_out]) # src изображение в качестве входа, сгенерированное изображение и выход классификации model = Model (in_src, [dis_out, gen_out]) # скомпилировать модель opt = Adam (lr = 0.0002, beta_1 = 0,5) model.compile (loss = [‘binary_crossentropy’, ‘mae’], optimizer = opt, loss_weights = [1,100]) return model |

Затем мы можем загрузить наш набор данных парных изображений в формате сжатого массива NumPy.

Это вернет список из двух массивов NumPy: первый для исходных изображений и второй для соответствующих целевых изображений.

# загрузить и подготовить обучающие изображения def load_real_samples (имя файла): # загружаем сжатые массивы данные = загрузка (имя файла) # распаковать массивы X1, X2 = данные [‘arr_0’], данные [‘arr_1’] # масштаб от [0,255] до [-1,1] Х1 = (Х1 — 127.5) / 127,5 Х2 = (Х2 — 127,5) / 127,5 возврат [X1, X2]

# загрузить и подготовить обучающие изображения def load_real_samples (filename): # загрузить сжатые массивы data = load (filename) # распаковать массивы X1, X2 = data [‘arr_0’], data [ ‘arr_1’] # масштаб от [0,255] до [-1,1] X1 = (X1 — 127,5) / 127,5 X2 = (X2 — 127,5) / 127.5 возврат [X1, X2] |

Для обучения дискриминатора потребуются пакеты реальных и поддельных изображений.

Функция generate_real_samples () ниже подготовит пакет случайных пар изображений из обучающего набора данных и соответствующую метку дискриминатора class = 1 , чтобы указать, что они реальны.

# выбираем партию случайных выборок, возвращаем изображения и выбираем def generate_real_samples (набор данных, n_samples, patch_shape): # распаковать набор данных trainA, trainB = набор данных # выбираем случайные экземпляры ix = randint (0, trainA.форма [0], n_samples) # получить выбранные изображения X1, X2 = поезд A [ix], поезд B [ix] # генерировать «настоящие» метки классов (1) y = единицы ((n_samples, patch_shape, patch_shape, 1)) return [X1, X2], y

# выбрать пакет случайных выборок, вернуть изображения и цель def generate_real_samples (dataset, n_samples, patch_shape): # распаковать набор данных trainA, trainB = dataset # выбрать случайные экземпляры ix = 0, поезд А.shape [0], n_samples) # извлекать выбранные изображения X1, X2 = trainA [ix], trainB [ix] # генерировать метки реальных классов (1) y = единицы ((n_samples, patch_shape , patch_shape, 1)) return [X1, X2], y |

Функция generate_fake_samples () ниже использует модель генератора и пакет реальных исходных изображений для создания эквивалентного пакета целевых изображений для дискриминатора.

Они возвращаются с меткой class-0, чтобы указать дискриминатору, что они поддельные.

# генерировать пакет изображений, возвращает изображения и цели def generate_fake_samples (g_model, samples, patch_shape): # создать поддельный экземпляр X = g_model.predict (образцы) # создать фальшивые метки классов (0) y = нули ((len (X), patch_shape, patch_shape, 1)) возврат X, y

# генерировать пакет изображений, возвращать изображения и цели def generate_fake_samples (g_model, samples, patch_shape): # генерировать поддельный экземпляр X = g_model.предсказать (образцы) # создать ‘поддельные’ метки классов (0) y = нули ((len (X), patch_shape, patch_shape, 1)) return X, y |

Обычно модели GAN не сходятся; вместо этого находится равновесие между моделями генератора и дискриминатора. Таким образом, мы не можем легко судить, когда следует прекратить тренировку. Следовательно, мы можем сохранить модель и использовать ее для периодического генерирования примеров преобразования изображения в изображение во время обучения, например, каждые 10 эпох обучения.

Затем мы можем просмотреть сгенерированные изображения в конце обучения и использовать качество изображения для выбора окончательной модели.

Функция summarize_performance () реализует это, беря модель генератора в момент обучения и используя ее для генерации числа, в данном случае трех, переводов случайно выбранных изображений в наборе данных. Затем исходное, сгенерированное изображение и ожидаемая цель отображаются в виде трех рядов изображений, а график сохраняется в файл. Кроме того, модель сохраняется в файл в формате H5, что упрощает загрузку в дальнейшем.

Имена файлов изображений и моделей включают номер итерации обучения, что позволяет нам легко различать их в конце обучения.

# сгенерировать образцы и сохранить как график и сохранить модель def summarize_performance (шаг, g_model, набор данных, n_samples = 3): # выбираем образец входных изображений [X_realA, X_realB], _ = generate_real_samples (набор данных, n_samples, 1) # создать партию поддельных образцов X_fakeB, _ = generate_fake_samples (g_model, X_realA, 1) # масштабировать все пиксели от [-1,1] до [0,1] X_realA = (X_realA + 1) / 2.0 X_realB = (X_realB + 1) / 2.0 X_fakeB = (X_fakeB + 1) / 2.0 # построить реальные исходные изображения для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + i) pyplot.axis (‘выключено’) pyplot.imshow (X_realA [i]) # сюжет сгенерировал целевое изображение для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + n_samples + i) pyplot.axis (‘выключено’) pyplot.imshow (X_fakeB [i]) # построить реальное целевое изображение для i в диапазоне (n_samples): пиплот.подзаговор (3, n_samples, 1 + n_samples * 2 + i) pyplot.axis (‘выключено’) pyplot.imshow (X_realB [i]) # сохранить график в файл filename1 = ‘plot_% 06d.png’% (шаг + 1) pyplot.savefig (имя_файла1) pyplot.close () # сохраняем модель генератора filename2 = ‘model_% 06d.h5’% (шаг + 1) g_model.save (имя_файла2) print (‘> Сохранено:% s и% s’% (имя_файла1, имя_файла2))

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 18 19 20 21 22 23 24 25 26 27 28 29 30 0003 | # сгенерировать образцы и сохранить как график и сохранить модель def summarize_performance (step, g_model, dataset, n_samples = 3): # выбрать образец входных изображений [X_realA, X_realB], _ = generate_real_samples (dataset, n_samples, 1) # создать пакет поддельных образцов X_fakeB, _ = generate_fake_samples (g_model, X_realA, 1) # масштабировать все пиксели от [-1,1] до [0,1] X_realA = (X_realA + 1) / 2.0 X_realB = (X_realB + 1) / 2.0 X_fakeB = (X_fakeB + 1) / 2.0 # построить реальные исходные изображения для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + i) pyplot.axis (‘off’) pyplot.imshow (X_realA [i]) # plot сгенерированное целевое изображение для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + n_samples + i) pyplot.axis (‘off’) pyplot.imshow (X_fakeB [i]) # построить реальное целевое изображение для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + n_samples * 2 + i) pyplot.axis (‘off ‘) pyplot.imshow (X_realB [i]) # сохранить график в файл filename1 =’ plot_% 06d.png ‘% (step + 1) pyplot.savefig (filename1) pyplot.close () # сохранить модель генератора filename2 = ‘model_% 06d.h5’% (step + 1) g_model.save (filename2) print (‘> Сохранено:% s и% s’% (filename1, filename2)) |

Наконец, мы можем обучить модели генератора и дискриминатора.

Функция train () ниже реализует это, принимая заданный генератор, дискриминатор, составную модель и загруженный набор данных в качестве входных данных. Количество эпох установлено на 100, чтобы сократить время обучения, хотя в статье использовалось 200. Размер партии 1 используется, как рекомендовано в статье.

Обучение включает фиксированное количество итераций обучения. В наборе обучающих данных 1097 изображений. Одна эпоха — это одна итерация по этому количеству примеров, при этом размер пакета, равный единице, означает 1097 шагов обучения. Генератор сохраняется и оценивается каждые 10 эпох или каждые 10970 обучающих шагов, а модель будет работать в течение 100 эпох, или всего 109 700 обучающих шагов.

Каждый шаг обучения включает в себя сначала выбор пакета реальных примеров, а затем использование генератора для создания пакета совпадающих поддельных образцов с использованием реальных исходных изображений.Затем дискриминатор обновляется пакетом реальных изображений, а затем — поддельными изображениями.

Затем модель генератора обновляется, предоставляя реальные исходные изображения в качестве входных данных и предоставляя метки классов 1 (реальные) и реальные целевые изображения в качестве ожидаемых выходных данных модели, необходимой для расчета потерь. Генератор имеет две оценки потерь, а также оценку взвешенной суммы, полученную при вызове train_on_batch () . Нас интересует только взвешенная сумма баллов (первое возвращаемое значение), поскольку она используется для обновления весов модели.

Наконец, потеря для каждого обновления сообщается на консоль на каждой итерации обучения, а производительность модели оценивается каждые 10 периодов обучения.

# поезд pix2pix модель def train (d_model, g_model, gan_model, набор данных, n_epochs = 100, n_batch = 1): # определяем выходную квадратную форму дискриминатора n_patch = d_model.output_shape [1] # распаковать набор данных trainA, trainB = набор данных # подсчитываем количество пакетов за период обучения bat_per_epo = интервал (len (trainA) / n_batch) # рассчитываем количество итераций обучения n_steps = bat_per_epo * n_epochs # вручную перечислить эпохи для i в диапазоне (n_steps): # выбрать партию реальных образцов [X_realA, X_realB], y_real = generate_real_samples (набор данных, n_batch, n_patch) # создать партию поддельных образцов X_fakeB, y_fake = generate_fake_samples (g_model, X_realA, n_patch) # обновить дискриминатор для реальных образцов d_loss1 = d_model.train_on_batch ([X_realA, X_realB], y_real) # обновить дискриминатор для сгенерированных образцов d_loss2 = d_model.train_on_batch ([X_realA, X_fakeB], y_fake) # обновить генератор g_loss, _, _ = gan_model.train_on_batch (X_realA, [y_real, X_realB]) # подвести итоги print (‘>% d, d1 [%. 3f] d2 [%. 3f] g [%. 3f]’% (i + 1, d_loss1, d_loss2, g_loss)) # подвести итоги работы модели если (i + 1)% (bat_per_epo * 10) == 0: summarize_performance (я, g_model, набор данных)

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 18 19 20 21 22 23 24 25 26 27 | # train pix2pix model def train (d_model, g_model, gan_model, dataset, n_epochs = 100, n_batch = 1): # определение выходной квадратной формы дискриминатора n_patch = d_model.output_shape [1] # распаковать набор данных trainA, trainB = dataset # вычислить количество пакетов на тренировочную эпоху bat_per_epo = int (len (trainA) / n_batch) # вычислить количество итераций обучения n_steps = bat_per_epo * n_epochs # вручную перечислить эпохи для i в диапазоне (n_steps): # выбрать партию реальных выборок [X_realA, X_realB], y_real_patch_realBase, y_real_patch_real_sample = (сгенерировать) # создать пакет поддельных образцов X_fakeB, y_fake = generate_fake_samples (g_model, X_realA, n_patch) # обновить дискриминатор для реальных образцов d_loss1 = d_model.train_on_batch ([X_realA, X_realB], y_real) # обновить дискриминатор для сгенерированных образцов d_loss2 = d_model.train_on_batch ([X_realA, X_fakeB], y_fake) # обновить генератор 9_dellossan, train_on_batch (X_realA, [y_real, X_realB]) # суммируем производительность print (‘>% d, d1 [%. 3f] d2 [%. 3f] g [%. 3f]’% (i + 1, d_loss1 , d_loss2, g_loss)) # суммировать производительность модели if (i + 1)% (bat_per_epo * 10) == 0: summarize_performance (i, g_model, dataset) |

Объединив все это вместе, ниже приведен полный пример кода для обучения Pix2Pix GAN преобразованию спутниковых фотографий в изображения Google Maps.

# пример pix2pix gan для спутника для преобразования изображения в изображение от нагрузки импорта numpy из numpy импортных нулей из множества импортных из numpy.random import randint от keras.optimizers импорт Адам из keras.initializers import RandomNormal из keras.models импорт модели from keras.models import Input из keras.layers импортировать Conv2D из keras.layers import Conv2DTranspose from keras.layers import LeakyReLU из кераса.активация импорта слоев из keras.layers import Concatenate из keras.layers import Dropout из keras.layers import BatchNormalization from keras.layers import LeakyReLU из matplotlib import pyplot # определяем модель дискриминатора def define_discriminator (image_shape): # инициализация веса init = RandomNormal (стандартное отклонение = 0,02) # вход исходного изображения in_src_image = Вход (shape = image_shape) # ввод целевого изображения in_target_image = Вход (shape = image_shape) # объединить изображения по каналам merged = Concatenate () ([in_src_image, in_target_image]) # C64 d = Conv2D (64, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (объединено) d = LeakyReLU (альфа = 0.2) (г) # C128 d = Conv2D (128, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (альфа = 0,2) (d) # C256 d = Conv2D (256, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (альфа = 0,2) (d) # C512 d = Conv2D (512, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (альфа = 0.2) (г) # второй последний выходной слой d = Conv2D (512, (4,4), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (альфа = 0,2) (d) # вывод патча d = Conv2D (1, (4,4), padding = ‘same’, kernel_initializer = init) (d) patch_out = Активация (‘сигмоид’) (d) # определить модель model = Модель ([in_src_image, in_target_image], patch_out) # скомпилировать модель opt = Адам (lr = 0,0002, beta_1 = 0,5) model.compile (loss = ‘binary_crossentropy’, optimizer = opt, loss_weights = [0.5]) модель возврата # определить блок кодировщика def define_encoder_block (layer_in, n_filters, batchnorm = True): # инициализация веса init = RandomNormal (стандартное отклонение = 0,02) # добавить слой понижающей дискретизации g = Conv2D (n_filters, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (layer_in) # условно добавить пакетную нормализацию если батчнорм: g = BatchNormalization () (g, обучение = True) # дырявая активация relu g = LeakyReLU (альфа = 0.2) (г) вернуть г # определяем блок декодера def decoder_block (layer_in, skip_in, n_filters, dropout = True): # инициализация веса init = RandomNormal (стандартное отклонение = 0,02) # добавить слой с повышающей дискретизацией g = Conv2DTranspose (n_filters, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (layer_in) # добавить пакетную нормализацию g = BatchNormalization () (g, обучение = True) # условно добавить отсев если бросил: g = выпадение (0,5) (g, обучение = верно) # объединить с пропустить соединение g = Concatenate () ([g, skip_in]) # активация relu g = Активация (‘relu’) (g) вернуть г # определить модель автономного генератора def define_generator (image_shape = (256,256,3)): # инициализация веса init = RandomNormal (stddev = 0.02) # ввод изображения in_image = Вход (shape = image_shape) # модель кодировщика e1 = define_encoder_block (in_image, 64, batchnorm = False) e2 = define_encoder_block (e1, 128) e3 = define_encoder_block (e2, 256) e4 = define_encoder_block (e3, 512) e5 = define_encoder_block (e4, 512) e6 = define_encoder_block (e5, 512) e7 = define_encoder_block (e6, 512) # бутылочное горлышко, без партии norm и relu b = Conv2D (512, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (e7) b = Активация (‘relu’) (b) # модель декодера d1 = decoder_block (b, e7, 512) d2 = decoder_block (d1, e6, 512) d3 = decoder_block (d2, e5, 512) d4 = decoder_block (d3, e4, 512, dropout = False) d5 = decoder_block (d4, e3, 256, dropout = False) d6 = decoder_block (d5, e2, 128, dropout = False) d7 = decoder_block (d6, e1, 64, dropout = False) # выход g = Conv2DTranspose (3, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d7) out_image = Активация (‘tanh’) (г) # определить модель model = Модель (in_image, out_image) модель возврата # определить комбинированную модель генератора и дискриминатора для обновления генератора def define_gan (g_model, d_model, image_shape): # сделать веса в дискриминаторе необучаемыми для слоя в d_model.слои: если не isinstance (слой, BatchNormalization): layer.trainable = Ложь # определяем исходное изображение in_src = Вход (shape = image_shape) # подключаем исходное изображение ко входу генератора gen_out = g_model (in_src) # подключаем вход источника и выход генератора ко входу дискриминатора dis_out = d_model ([in_src, gen_out]) # src image как вход, сгенерированное изображение и вывод классификации model = Модель (in_src, [dis_out, gen_out]) # скомпилировать модель opt = Адам (lr = 0.0002, beta_1 = 0,5) model.compile (loss = [‘binary_crossentropy’, ‘mae’], optimizer = opt, loss_weights = [1,100]) модель возврата # загрузить и подготовить обучающие изображения def load_real_samples (имя файла): # загружаем сжатые массивы данные = загрузка (имя файла) # распаковать массивы X1, X2 = данные [‘arr_0’], данные [‘arr_1’] # масштаб от [0,255] до [-1,1] X1 = (X1 — 127,5) / 127,5 Х2 = (Х2 — 127,5) / 127,5 return [X1, X2] # выбираем партию случайных выборок, возвращаем изображения и выбираем def generate_real_samples (набор данных, n_samples, patch_shape): # распаковать набор данных trainA, trainB = набор данных # выбираем случайные экземпляры ix = randint (0, trainA.форма [0], n_samples) # получить выбранные изображения X1, X2 = поезд A [ix], поезд B [ix] # генерировать «настоящие» метки классов (1) y = единицы ((n_samples, patch_shape, patch_shape, 1)) return [X1, X2], y # генерировать пакет изображений, возвращает изображения и цели def generate_fake_samples (g_model, samples, patch_shape): # создать поддельный экземпляр X = g_model.predict (образцы) # создать фальшивые метки классов (0) y = нули ((len (X), patch_shape, patch_shape, 1)) вернуть X, y # сгенерировать образцы и сохранить как график и сохранить модель def summarize_performance (шаг, g_model, набор данных, n_samples = 3): # выбираем образец входных изображений [X_realA, X_realB], _ = generate_real_samples (набор данных, n_samples, 1) # создать партию поддельных образцов X_fakeB, _ = generate_fake_samples (g_model, X_realA, 1) # масштабировать все пиксели от [-1,1] до [0,1] X_realA = (X_realA + 1) / 2.0 X_realB = (X_realB + 1) / 2.0 X_fakeB = (X_fakeB + 1) / 2.0 # построить реальные исходные изображения для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + i) pyplot.axis (‘выключено’) pyplot.imshow (X_realA [i]) # сюжет сгенерировал целевое изображение для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + n_samples + i) pyplot.axis (‘выключено’) pyplot.imshow (X_fakeB [i]) # построить реальное целевое изображение для i в диапазоне (n_samples): пиплот.подзаговор (3, n_samples, 1 + n_samples * 2 + i) pyplot.axis (‘выключено’) pyplot.imshow (X_realB [i]) # сохранить график в файл filename1 = ‘plot_% 06d.png’% (шаг + 1) pyplot.savefig (имя_файла1) pyplot.close () # сохраняем модель генератора filename2 = ‘model_% 06d.h5’% (шаг + 1) g_model.save (имя_файла2) print (‘> Сохранено:% s и% s’% (имя_файла1, имя_файла2)) # поезд модели pix2pix def train (d_model, g_model, gan_model, набор данных, n_epochs = 100, n_batch = 1): # определяем выходную квадратную форму дискриминатора n_patch = d_model.output_shape [1] # распаковать набор данных trainA, trainB = набор данных # подсчитываем количество пакетов за период обучения bat_per_epo = интервал (len (trainA) / n_batch) # рассчитываем количество итераций обучения n_steps = bat_per_epo * n_epochs # вручную перечислить эпохи для i в диапазоне (n_steps): # выбрать партию реальных образцов [X_realA, X_realB], y_real = generate_real_samples (набор данных, n_batch, n_patch) # создать партию поддельных образцов X_fakeB, y_fake = generate_fake_samples (g_model, X_realA, n_patch) # обновить дискриминатор для реальных образцов d_loss1 = d_model.train_on_batch ([X_realA, X_realB], y_real) # обновить дискриминатор для сгенерированных образцов d_loss2 = d_model.train_on_batch ([X_realA, X_fakeB], y_fake) # обновить генератор g_loss, _, _ = gan_model.train_on_batch (X_realA, [y_real, X_realB]) # подвести итоги print (‘>% d, d1 [%. 3f] d2 [%. 3f] g [%. 3f]’% (i + 1, d_loss1, d_loss2, g_loss)) # подвести итоги работы модели если (i + 1)% (bat_per_epo * 10) == 0: summarize_performance (я, g_model, набор данных) # загрузить данные изображения набор данных = load_real_samples (‘maps_256.нпз ‘) print (‘Загружено’, набор данных [0] .shape, набор данных [1] .shape) # определить форму ввода на основе загруженного набора данных image_shape = набор данных [0] .shape [1:] # определить модели d_model = define_discriminator (image_shape) g_model = define_generator (image_shape) # определить составную модель gan_model = define_gan (g_model, d_model, image_shape) # модель поезда поезд (d_model, g_model, gan_model, набор данных)

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 18 19 20 21 22 23 24 25 26 27 28 29 30 000 000 34 35 36 37 38 39 40 41 42 43 44 45 46 48 00030002 47000351 52 53 54 55 56 57 58 59 60 61 62 63 9 0002 6465 66 67 68 69 70 71 72 73 74 75 76 77 81 82 83 84 85 86 87 88 89 90 91 92 93 000 93 000 97 98 99 100 101 102 103 104 105 106 107 108 109 1102 109 1102 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 13 136 137 1382 138 137 138 142 143 144 145 146 147 148 149 150 151 152 153 153 153 158 159 160 161 162 163 164 165 166 167 168 169 000 000 170002 1700009 175 176 177 178 179 180 181 182 183 9000 3 184 185 186 187 188 189 190 191 192 193 194 195 000 1 0003 0003 1 200201 202 203 204 205 206 207 208 209 210 211 212 0003 212 0003 211 212 0003 217 218 219 220 221 222 223 224 225 226 227 228 000 227 228 000 0003 228 000 0003 228 000 234 235 236 237 238 239 240 241 242 9 0003 243 244 | # пример pix2pix gan для спутника для преобразования изображения в изображение из numpy import load from numpy import zeros from numpy import ones from numpy.random import randint from keras.optimizers import Adam from keras.initializers import RandomNormal from keras.models import Model from keras.models import Input from keras.layers import Conv2D import from keras.layers Conv2DTranspose из keras.layers import LeakyReLU from keras.layers import Activation from keras.layers import Concatenate from keras.layers import Dropout from keras.Layers import BatchNormalization from keras.layers import LeakyReLU from matplotlib import pyplot # определить модель дискриминатора def define_discriminator (image_shape): # инициализация веса # исходное изображение input in_src_image = Input (shape = image_shape) # целевое изображение input in_target_image = Input (shape = image_shape) # объединять изображения по каналам merged = Concatenate, () in_target_image]) # C64 d = Conv2D (64, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (объединено) d = LeakyReLU (alpha = 0.2) (d) # C128 d = Conv2D (128, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization ( ) (d) d = LeakyReLU (alpha = 0.2) (d) # C256 d = Conv2D (256, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (alpha = 0.2) (d) # C512 d = Conv2D (512, (4,4), шаги = ( 2,2), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (alpha = 0.2) (d) # второй последний выходной слой d = Conv2D (512, (4,4), padding = ‘same’, kernel_initializer = init) (d) d = BatchNormalization () (d) d = LeakyReLU (alpha = 0.2) (d) # вывод патча d = Conv2D (1, (4,4), padding = ‘same’, kernel_initializer = init) (d) patch_out = Activation ( ‘sigmoid’) (d) # определить модель model = Model ([in_src_image, in_target_image], patch_out) # скомпилировать модель opt = Adam (lr = 0.0002, beta_1 = 0,5) model.compile (loss = ‘binary_crossentropy’, optimizer = opt, loss_weights = [0,5]) return model # определить блок кодировщика def define_encoder_block (layer_in, n_filters, batchnorm = True): # инициализация веса init = RandomNormal (stddev = 0,02) # добавить слой понижающей дискретизации g = Conv2D (n_filters, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (layer_in) # условно добавить пакетную нормализацию , если batchnorm: g = BatchNormalization () (g, training = True) # активация утечки relu g = LeakyReLU (alpha = 0.2) (g) return g # определение блока декодера def decoder_block (layer_in, skip_in, n_filters, dropout = True): # инициализация веса init = RandomNormal (std0003 = 0,02) # добавить слой с повышающей дискретизацией g = Conv2DTranspose (n_filters, (4,4), strides = (2,2), padding = ‘same’, kernel_initializer = init) (layer_in) # добавить пакетную нормализацию g = BatchNormalization () (g, training = True) # условно добавить выпадение если выпадение: g = выпадение (0.5) (g, training = True) # слияние с пропуском соединения g = Concatenate () ([g, skip_in]) # повторная активация g = Activation (‘relu’) (g) return g # определение модели автономного генератора def define_generator (image_shape = (256,256,3)): # инициализация веса init = RandomNormal (stddev = 0.02) # image input in_image Ввод (shape = image_shape) # модель кодировщика e1 = define_encoder_block (in_image, 64, batchnorm = False) e2 = define_encoder_block (e1, 128) e3 = define_encoder_block2 9 = define_encoder_block4 (e2 (e3, 512) e5 = define_encoder_block (e4, 512) e6 = define_encoder_block (e5, 512) e7 = define_encoder_block (e6, 512) # узкое место, нет batch norm2D и relu (512, (4,4), шаги = (2,2), паддин g = ‘same’, kernel_initializer = init) (e7)b = Активация (‘relu’) (b) # модель декодера d1 = decoder_block (b, e7, 512) d2 = decoder_block (d1 , e6, 512) d3 = decoder_block (d2, e5, 512) d4 = decoder_block (d3, e4, 512, dropout = False) d5 = decoder_block (d4, e3, 256, dropout = False) d6 = decoder_block (d5, e2, 128, dropout = False) d7 = decoder_block (d6, e1, 64, dropout = False) # output g = Conv2DTranspose (3, (4,4), шаги = (2,2), padding = ‘same’, kernel_initializer = init) (d7) out_image = Activation (‘tanh’) (g) # определить модель model = Model (in_image, out_image) return model # определить комбинированную модель генератора и дискриминатора, для обновления генератора def define_gan (g_model, d_model, image_shape): # сделать веса в дискриминаторе не обучать в состоянии для слоя в d_model.Layers: if not isinstance (layer, BatchNormalization): layer.trainable = False # определить исходное изображение in_src = Input (shape = image_shape) # подключить исходное изображение ко входу генератора gen_out = g_model (in_src) # подключите вход источника и выход генератора к входу дискриминатора dis_out = d_model ([in_src, gen_out]) # src изображение в качестве входа, сгенерированное изображение и выход классификации model = Model (in_src, [dis_out, gen_out]) # скомпилировать модель opt = Adam (lr = 0.0002, beta_1 = 0,5) model.compile (loss = [‘binary_crossentropy’, ‘mae’], optimizer = opt, loss_weights = [1,100]) return model # загрузить и подготовить обучающие изображения def load_real_samples (filename): # загрузить сжатые массивы data = load (filename) # распаковать массивы X1, X2 = data [‘arr_0’], data [‘arr_1’] # масштаб от [ 0,255] до [-1,1] X1 = (X1 — 127,5) / 127,5 X2 = (X2 — 127.5) / 127,5 return [X1, X2] # выбор пакета случайных выборок, возврат изображений и цель def generate_real_samples (dataset, n_samples, patch_shape): # unpack dataset trainA = набор данных # выбрать случайные экземпляры ix = randint (0, trainA.shape [0], n_samples) # получить выбранные изображения X1, X2 = trainA [ix], trainB [ix] # сгенерировать ‘реальные’ метки класса (1) y = единицы ((n_samples, patch_shape, patch_shape, 1)) return [X1, X2], y # генерировать пакет изображений, возвращает изображения и цели def generate_fake_samples (g_model, samples, patch_shape): # генерировать поддельный экземпляр X = g_model.предсказать (образцы) # создать ‘поддельные’ метки классов (0) y = нули ((len (X), patch_shape, patch_shape, 1)) return X, y # создать образцы и сохранить как график и сохраните модель def summarize_performance (step, g_model, dataset, n_samples = 3): # выберите образец входных изображений [X_realA, X_realB], _ = generate_real_samples (dataset, n_samples, 1) # создать пакет поддельных образцов X_fakeB, _ = generate_fake_samples (g_model, X_realA, 1) # масштабировать все пиксели от [-1,1] до [0,1] X_realA = (X_realA + 1 ) / 2.0 X_realB = (X_realB + 1) / 2.0 X_fakeB = (X_fakeB + 1) / 2.0 # построить реальные исходные изображения для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + i) pyplot.axis (‘off’) pyplot.imshow (X_realA [i]) # plot сгенерированное целевое изображение для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + n_samples + i) pyplot.axis (‘off’) pyplot.imshow (X_fakeB [i]) # построить реальное целевое изображение для i в диапазоне (n_samples): pyplot.subplot (3, n_samples, 1 + n_samples * 2 + i) pyplot.axis (‘off ‘) pyplot.imshow (X_realB [i]) # сохранить график в файл filename1 =’ plot_% 06d.png ‘% (step + 1) pyplot.savefig (filename1) pyplot.close () # сохранить модель генератора filename2 = ‘model_% 06d.h5’% (step + 1) g_model.save (filename2) print (‘> Сохранено:% s и% s’% (filename1, filename2)) # train pix2pix models def train (d_model, g_model, gan_model, dataset, n_epochs = 100, n_batch = 1): # определить выходную квадратную форму дискриминатора n_patch = d_model.output_shape [1] # распаковать набор данных trainA, trainB = dataset # вычислить количество пакетов за период обучения bat_per_epo = int (len (trainA) / n_batch) # вычислить количество обучающих итераций n_steps = bat_per_epo * n_epochs # вручную перечислить эпохи для i in range (n_3000 batch): # 9000 batch реальных образцов [X_realA, X_realB], y_real = generate_real_samples (dataset, n_batch, n_patch) # сгенерировать партию поддельных образцов X_fakeB, y_fake = generate_fake_samples (g_model_ 9_real) 0002 # обновить дискриминатор для реальных отсчетов d_loss1 = d_model.train_on_batch ([X_realA, X_realB], y_real) # обновить дискриминатор для сгенерированных выборок d_loss2 = d_model.train_on_batch ([X_realA, X_fakeB], y_fake) # обновить генератор 9_dellossan, train_on_batch (X_realA, [y_real, X_realB])# суммируем производительность print (‘>% d, d1 [%. 3f] d2 [%. 3f] g [%. 3f]’% (i + 1, d_loss1 , d_loss2, g_loss)) # суммировать производительность модели if (i + 1)% (bat_per_epo * 10) == 0: summarize_performance (i, g_model, dataset) # загрузить данные изображения набор данных = load_real_samples (‘maps_256.npz ‘)print (‘ Loaded ‘, dataset [0] .shape, dataset [1] .shape) # определить входную форму на основе загруженного набора данных image_shape = dataset [0] .shape [1:] # определить модели d_model = define_discriminator (image_shape) g_model = define_generator (image_shape) # определить составную модель gan_model = define_gan (g_model d_model, train_model, train_model, train_model) d_model, g_model, gan_model, набор данных) |

Пример можно запустить на аппаратном обеспечении ЦП, хотя рекомендуется аппаратное обеспечение ГП.

Пример может занять около двух часов на современном оборудовании с графическим процессором.

Примечание : Ваши результаты могут отличаться из-за стохастической природы алгоритма или процедуры оценки или различий в числовой точности. Вы можете повторить пример несколько раз и сравнить средний результат.